Баланс пример ип: Бухгалтерская отчетность ИП — Контур.Бухгалтерия — СКБ Контур

Бухгалтерская отчетность ИП — Контур.Бухгалтерия — СКБ Контур

Какую отчетность сдает ИП

Предприниматель может не вести бухучет и не сдавать бухгалтерскую отчетность в налоговую. Это обязательная задача организаций, но не предпринимателей (пп. 1 п. 2 ст. 6 ФЗ от 06.12.2011 №402-ФЗ “О бухгалтерском учете”).

При этом бухучет со спецсчетами и проводками можно не вести, только если ИП другим способом ведет учет доходов, расходов и прочих объектов налогообложения (ст. 6 402-ФЗ от 06.12.2011). На основе такого учета он формирует отчеты для налоговой. Так что от сдачи бухгалтерских форм отчетности предприниматель освобожден, но обязательно сдает в ФНС налоговую отчетность. Перечень отчетных деклараций и других документов определяется налоговым режимом, на котором работает ИП:

- на ОСНО это декларация 3-НДФЛ, декларация по НДС с книгой покупок и продаж, обязательно ведется КУДиР, утвержденная приказом Минфина от 13.08.2002 № 86н/БГ-3-04/430;

- на УСН — декларация по УСН, обязательно ведется КУДиР, утвержденная приказом Минфина №135н от 22.

- на патенте — обязательно ведется КУД, утвержденная приказом Минфина №135н от 22.10.2012;

- на ЕСХН — декларация по ЕСХН, обязательно ведется КУДиР, утвержденная приказом Минфина №169н от 11.12.2006 (в ред. от 31.12.2008).

А еще ИП-работодатель сдает отчеты по сотрудникам: РСВ, СЗВ-М, СЗВ-ТД, СЗВ-СТАЖ, 4-ФСС, 6-НДФЛ.

Какие документы заменяют бухотчетность у ИП

Есть случаи, когда предпринимателей просят подготовить промежуточную бухгалтерскую отчетность — для получения кредита или участия в тендере. Бухотчетность запрашивают и контрагенты перед заключением серьезных сделок.

Если ИП не ведет бухучет и не составляет бухотчетность, он может представить для этих целей выписку из КУДиР или КУД и декларацию по налогу за истекший период. А еще приложить к этим документам письмо о том, что предприниматель не составляет бухотчетность в соответствии с правом, которое дает ему 402-ФЗ “О бухгалтерском учете”.

В Контур.Бухгалтерии ИП может распечатать КУДиР и налоговую декларацию за истекший период с отметкой ФНС о приеме.

Вот образец сопроводительного письма, которое ИП может вместе с документами предоставить в банк, на тендер или контрагенту:

«Я, ИП Иванов И.И., настоящим письмом уведомляю, что не могу предоставить бухгалтерскую отчетность за указанный период, поскольку не веду бухгалтерский учет. Такая возможность предусмотрена пп.1 п.2 ст.6 Федерального закона “О бухгалтерском учете” №402-ФЗ от 06.12.2011. Взамен предоставляю налоговую отчетность с отметкой ФНС о приеме и/или выписку из Книги учета доходов и расходов».

Какую отчетность сдают ООО и ИП при УСН в 2020 году

Упрощенную систему могут применять предприниматели и организации, которые соответствуют установленным критериям. И те, и другие в большинстве случаев платят только единый налог, а вот учет и отчетность УСН у организаций сложнее. Из этой статьи вы узнаете, какую отчетность сдают упрощенцы.

Она сдается по единой форме независимо от объекта налогообложения: «доходы» или «доходы за минусом расходов», просто для каждого случая в декларации есть свой раздел. В 2020 году действует форма, утверждённая Приказом ФНС России № ММВ-7-3/99 от 26.02.2016г.

В 2020 году действует форма, утверждённая Приказом ФНС России № ММВ-7-3/99 от 26.02.2016г.

Срок сдачи отчетности УСН для предпринимателей 30 апреля после отчетного года, для организаций – 31 марта.

Заполнять ее можно как в электронном виде, так и в бумажном. Те, у кого в штате меньше 100 сотрудников могут делать как им удобно, а вот если сотрудников больше 100, то вариантов нет – отчет нужно отправить в электронной форме.

В сервисе «Мое дело» декларации формируются с помощью пошагового мастера, который не даст что-то пропустить или ошибиться.

Она тоже обязательна для всех. Информация из КУДиР нужна для заполнения декларации и расчета налогов, а также для налоговых проверок. Актуальную форму можно найти в приложении 1 к Приказу Минфина России от 22.10.2012 № 135н, а порядок заполнения – в приложении 2.

Пользователям сервиса «Мое дело» нет необходимости искать форму и изучать правила заполнения, ведь в системе все формируется автоматически и по действующим правилам.

Если вести КУДиР в электронном виде, то после окончания отчетного периода нужно ее распечатать, прошить и подписать. В таком виде она должна храниться, чтобы ее можно было по первому требованию предъявить налоговикам для проверки.

Если деятельность не велась, книгу все равно нужно сформировать с нулевыми показателями и распечатать, ее отсутствие карается штрафом.

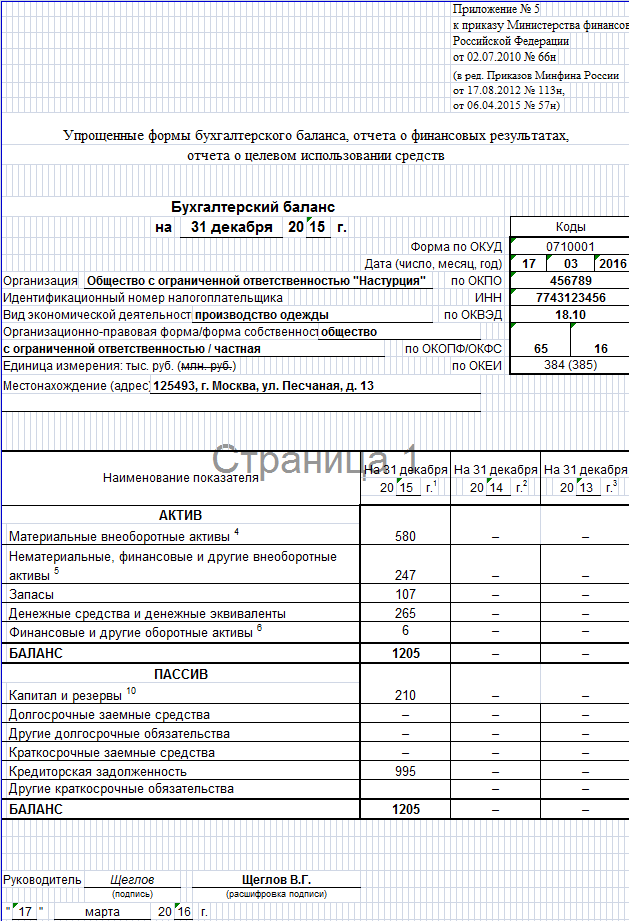

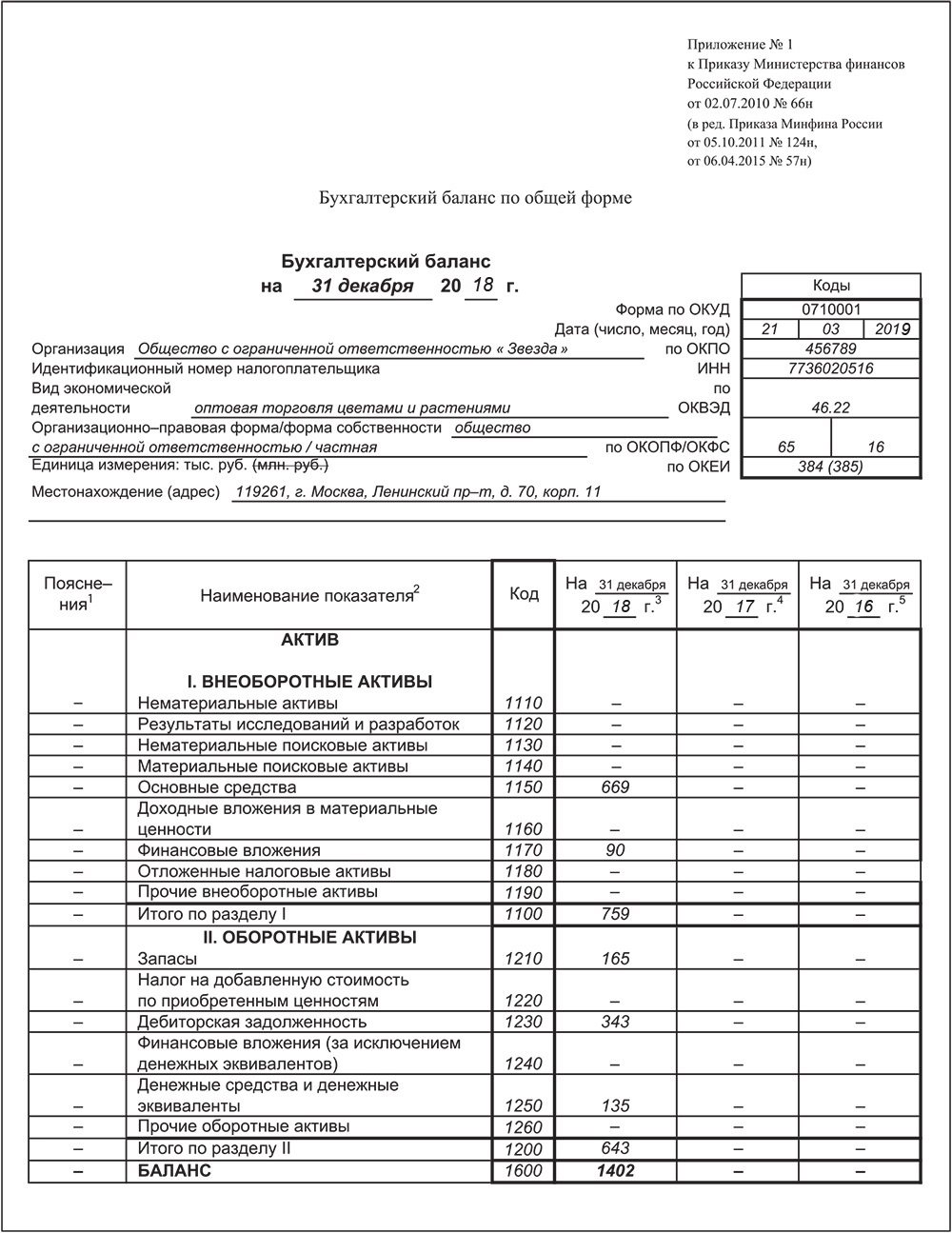

А вот этот раздел только для организаций, предприниматели могут его пропустить, потому что освобождены от необходимости вести бухгалтерский учет.

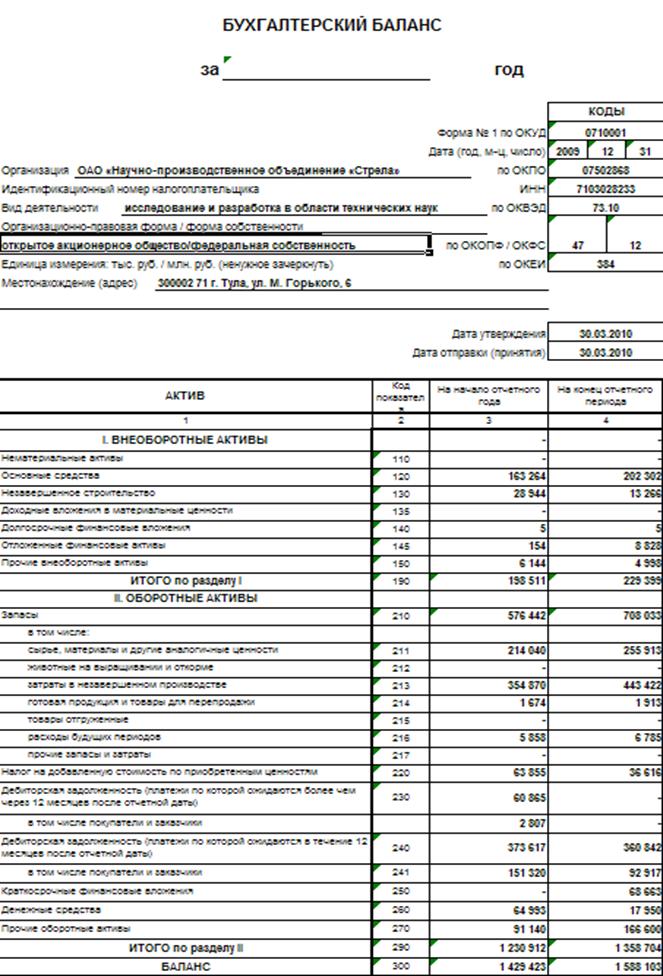

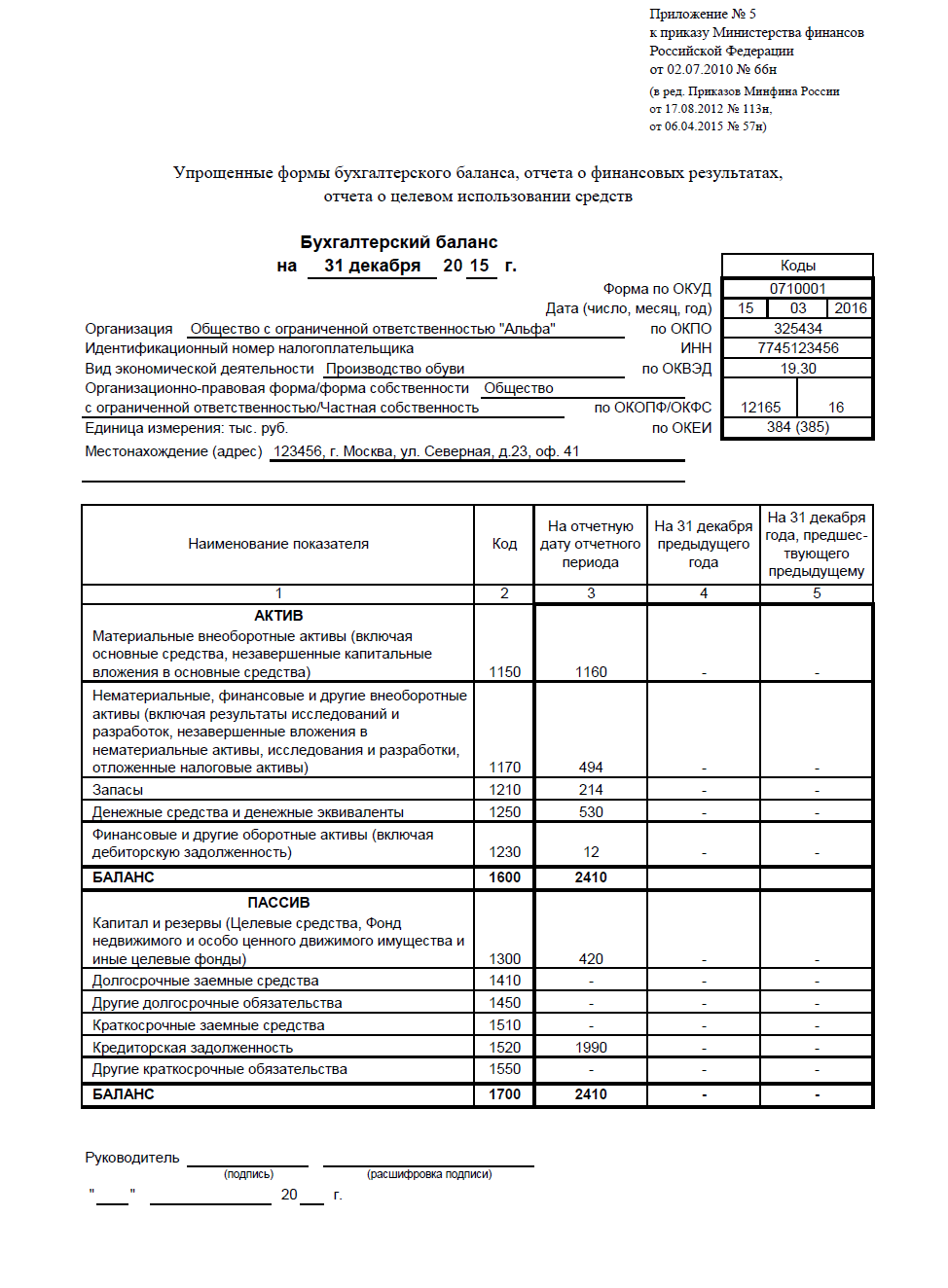

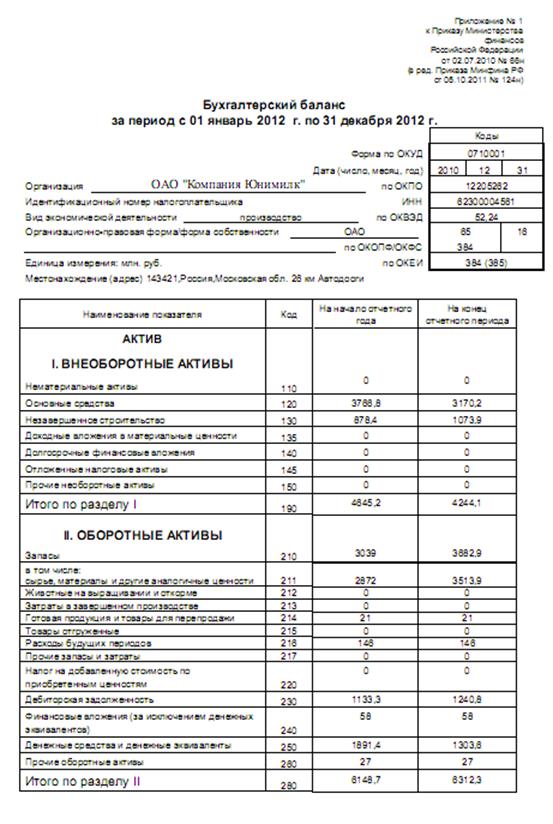

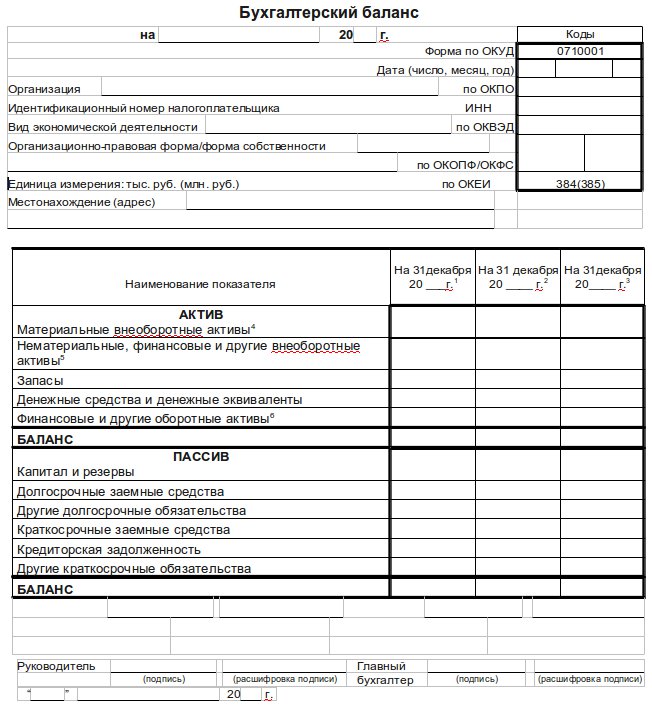

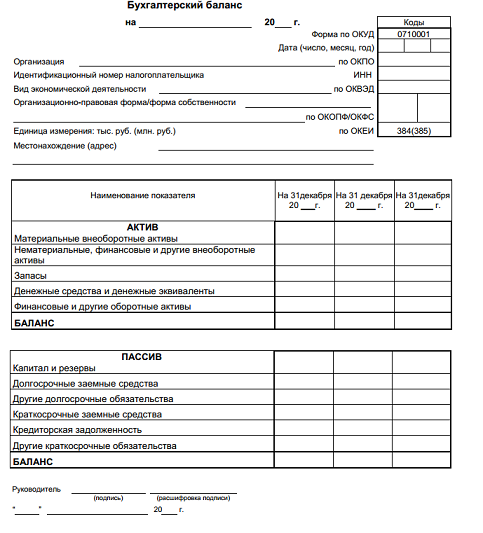

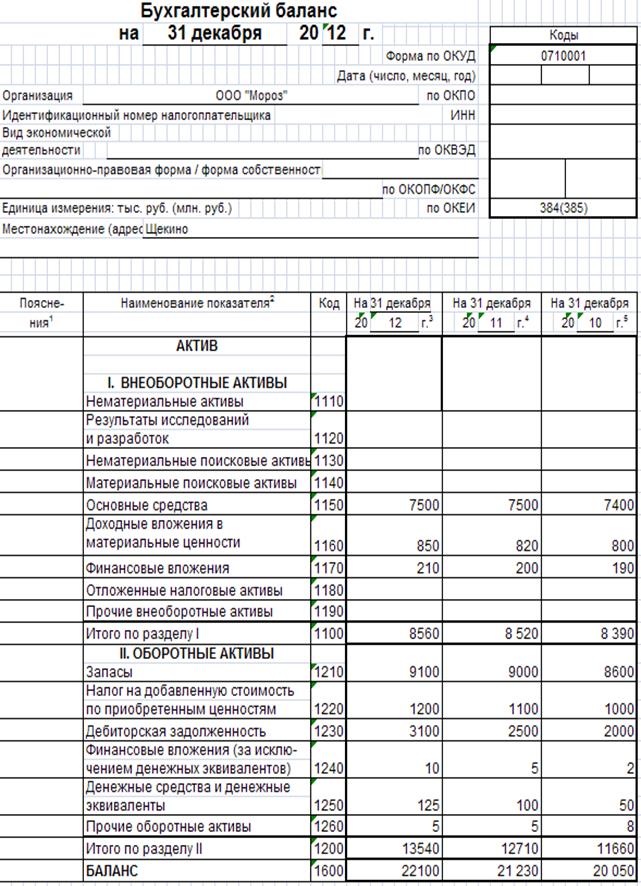

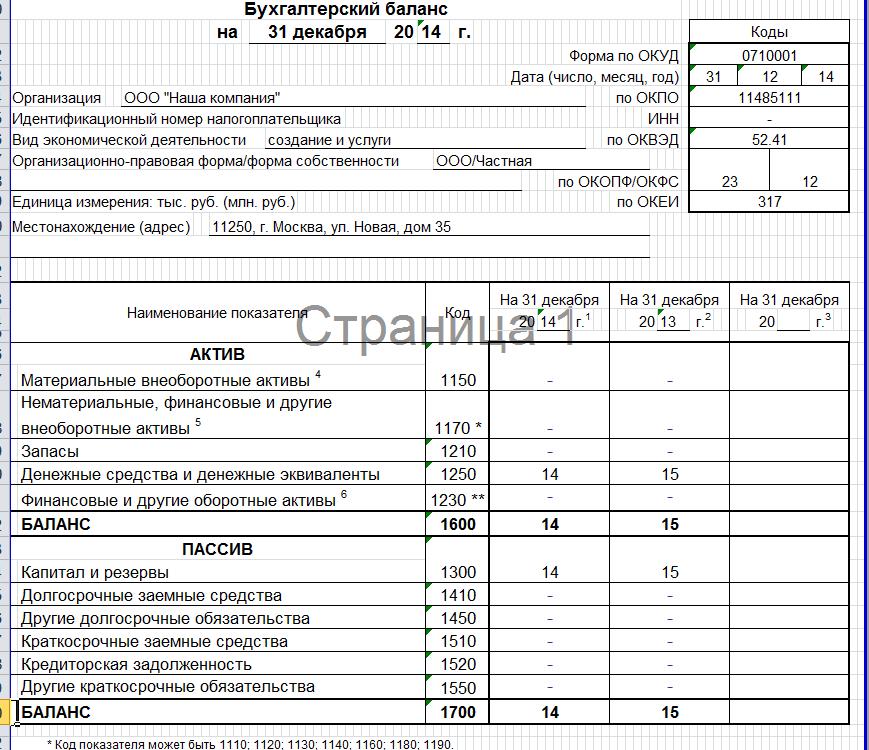

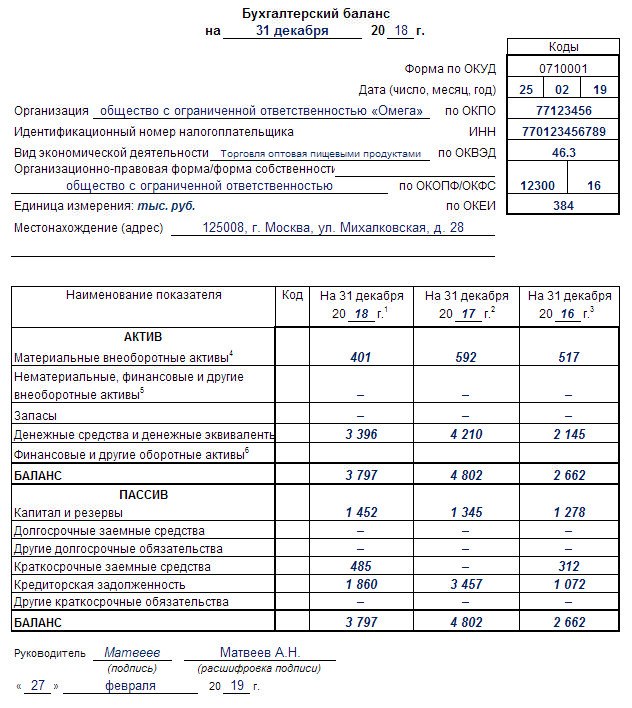

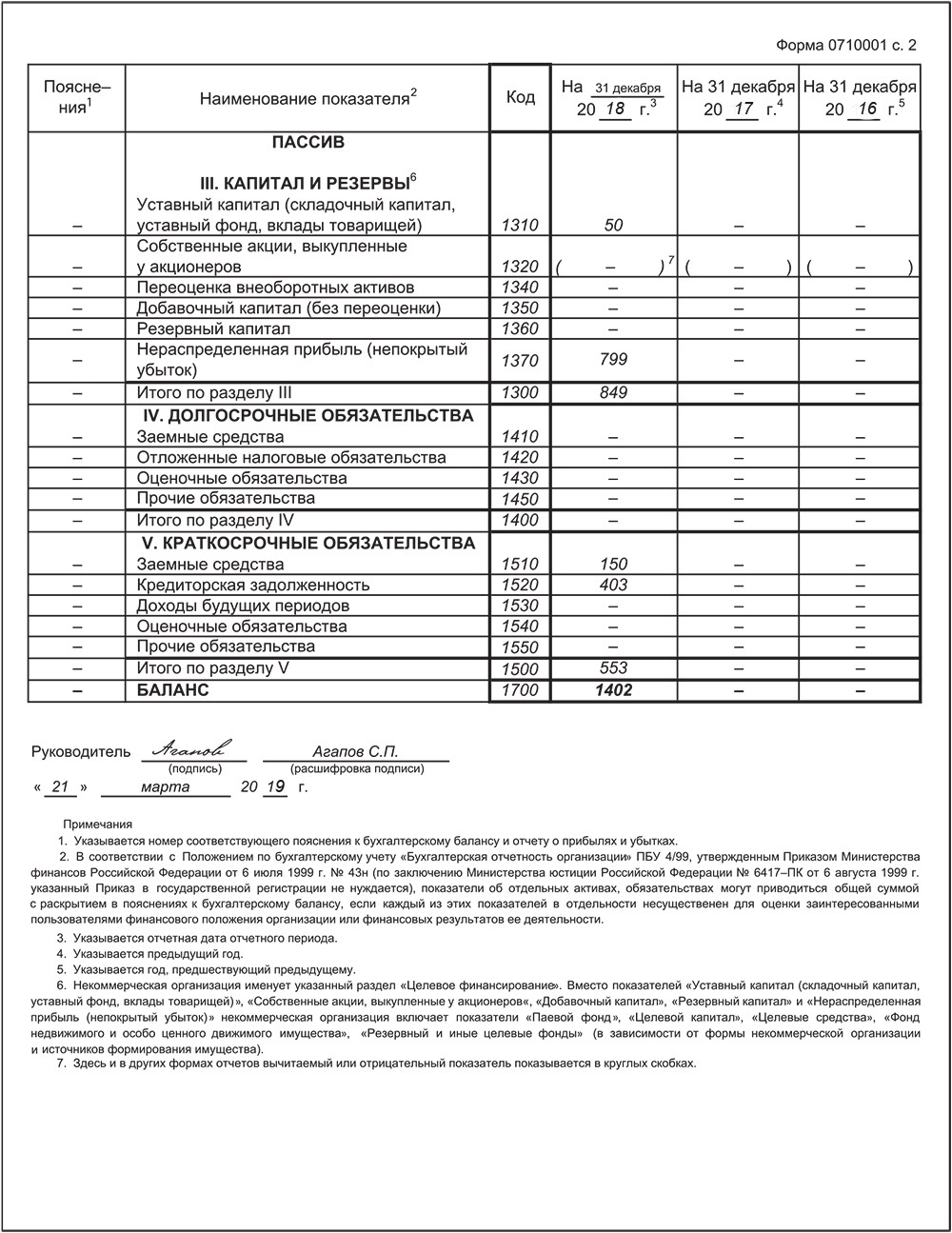

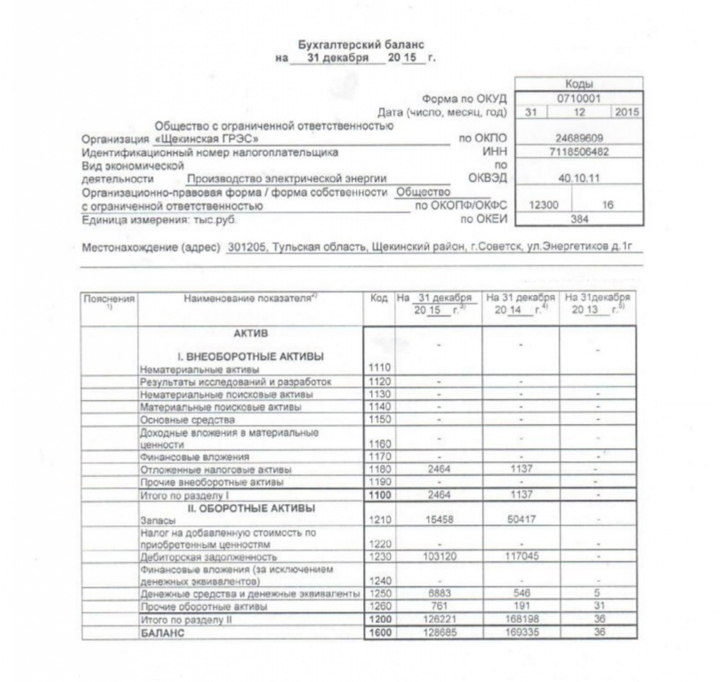

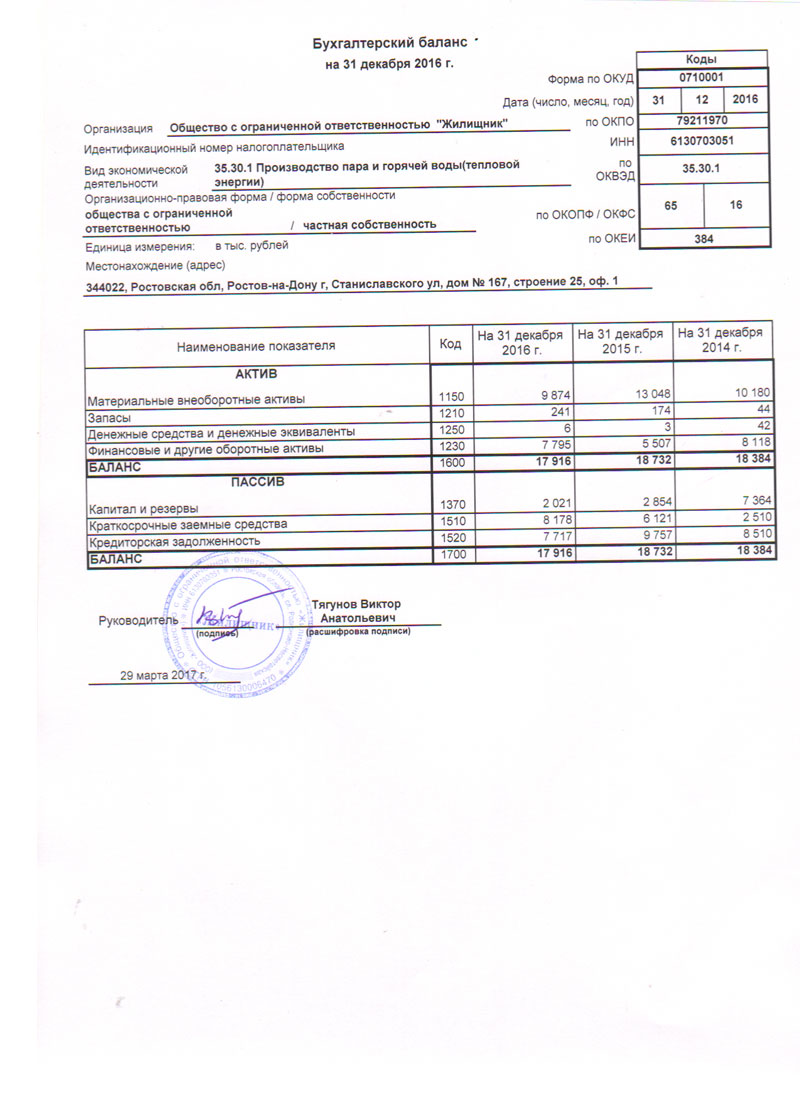

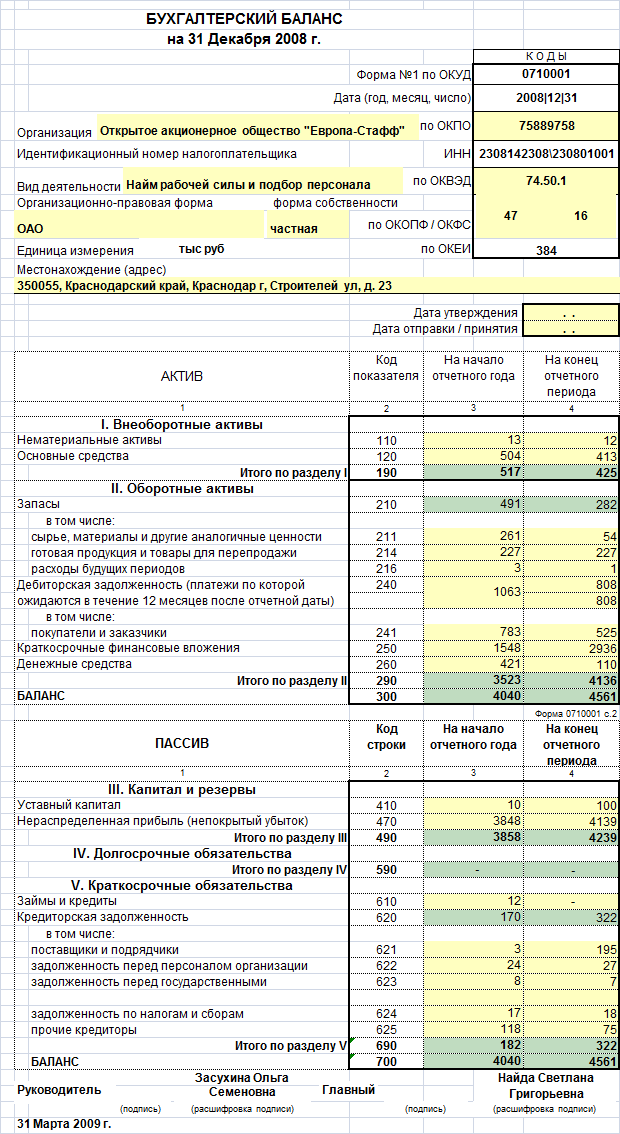

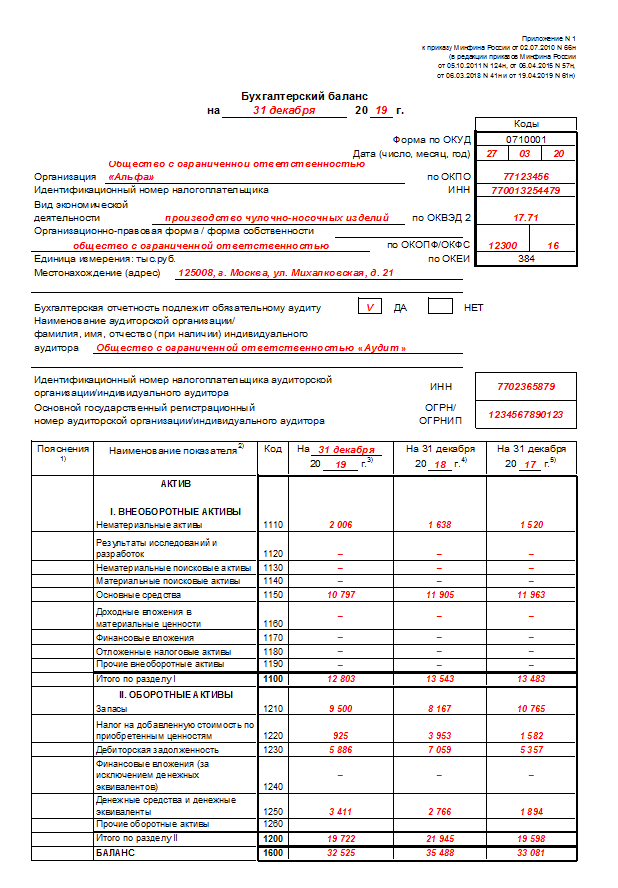

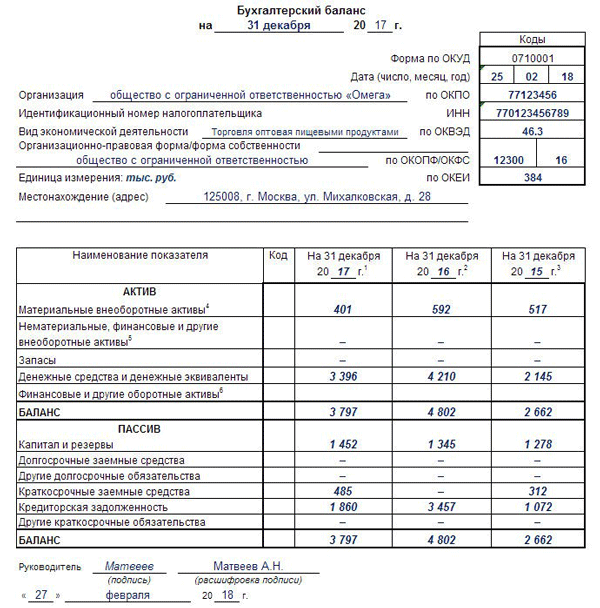

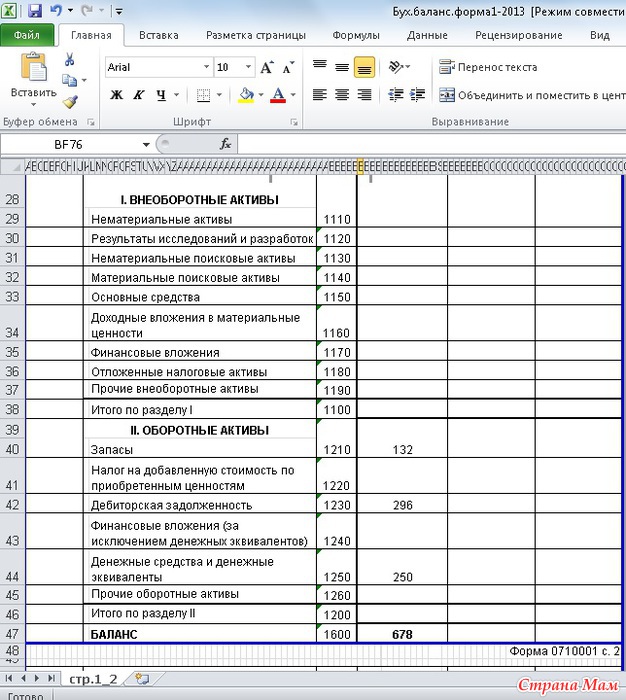

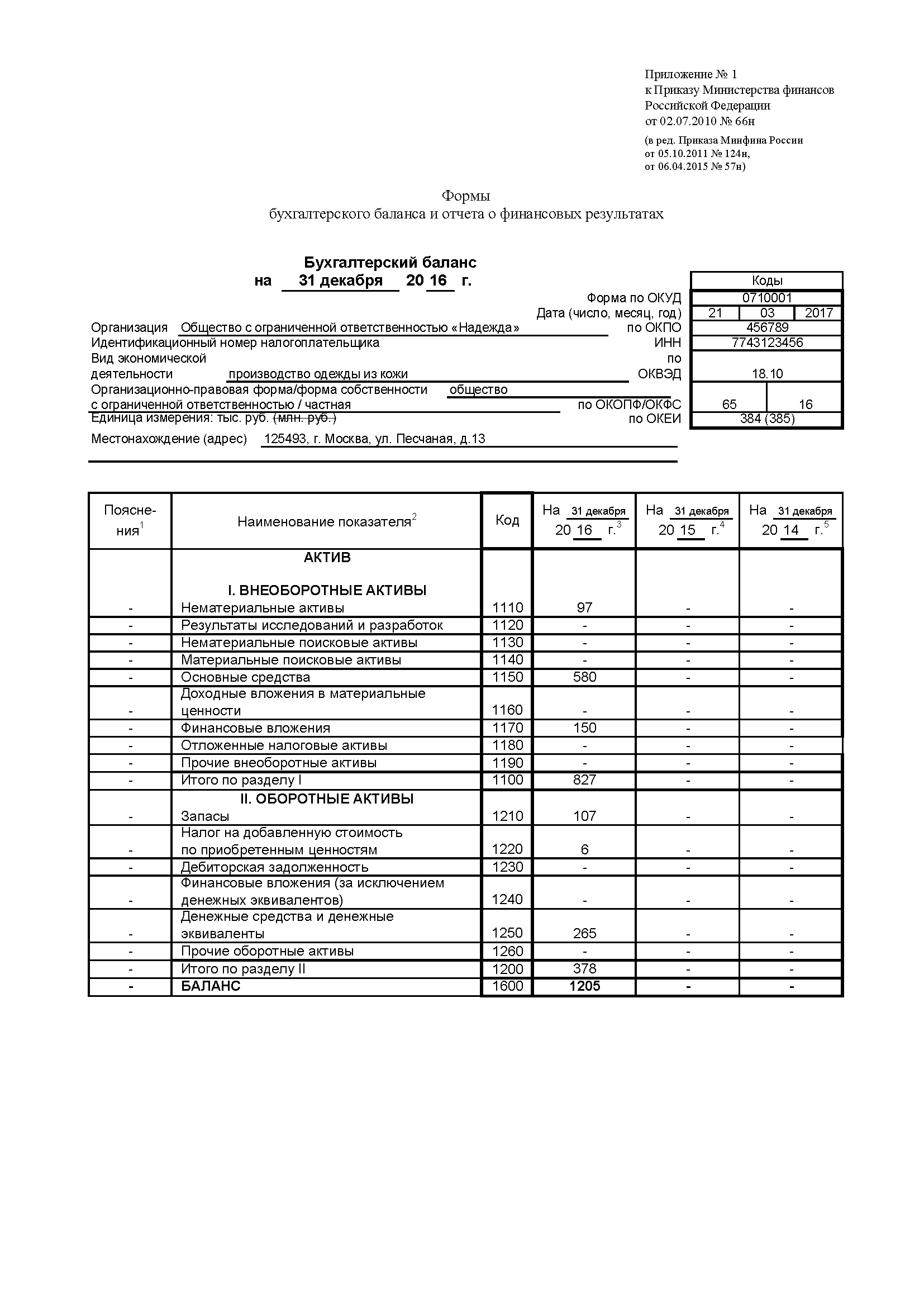

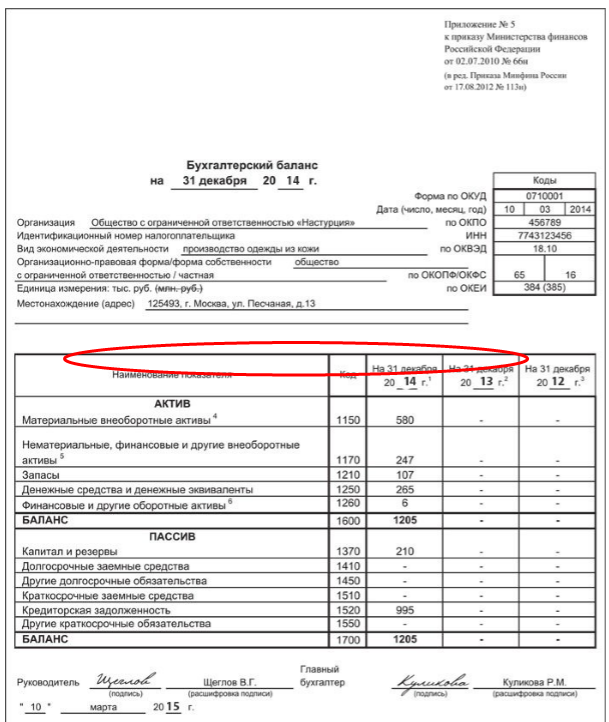

Каждый год до 31 марта ООО на УСН должны сформировать и сдать бухгалтерский баланс.

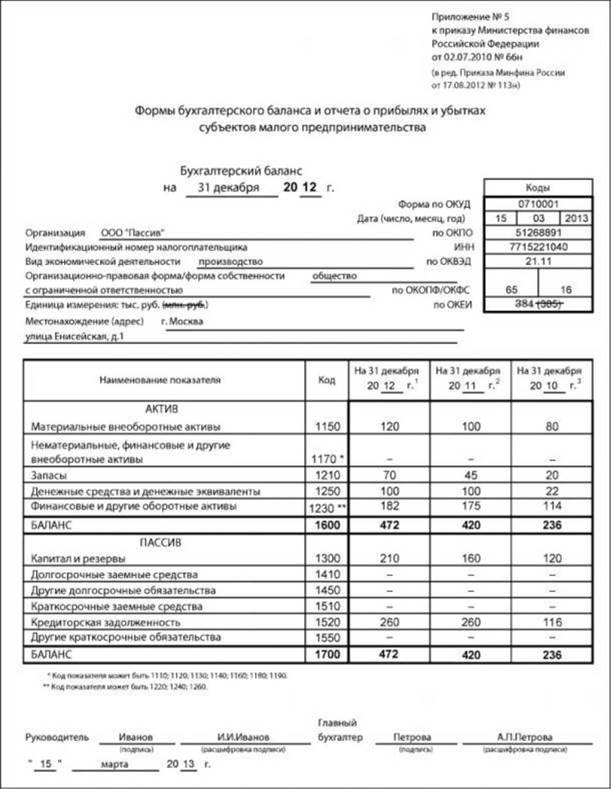

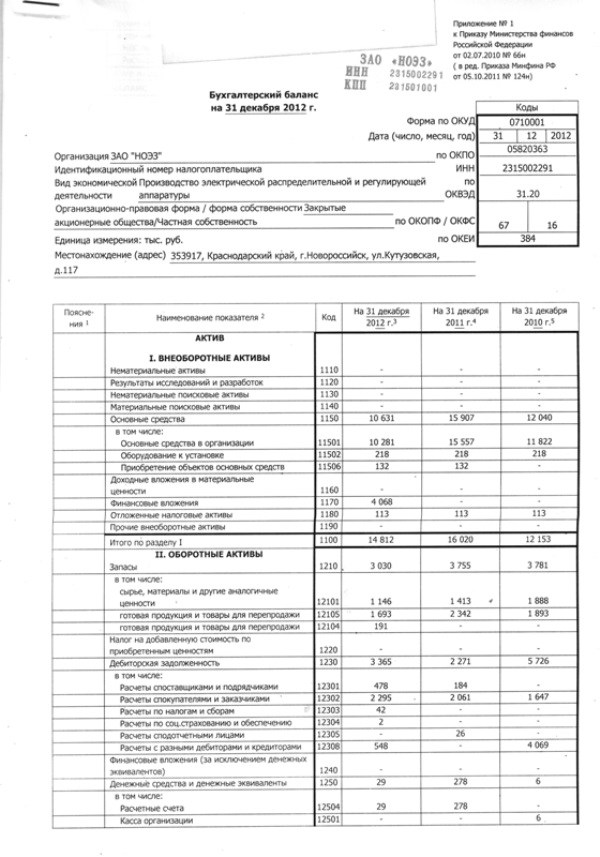

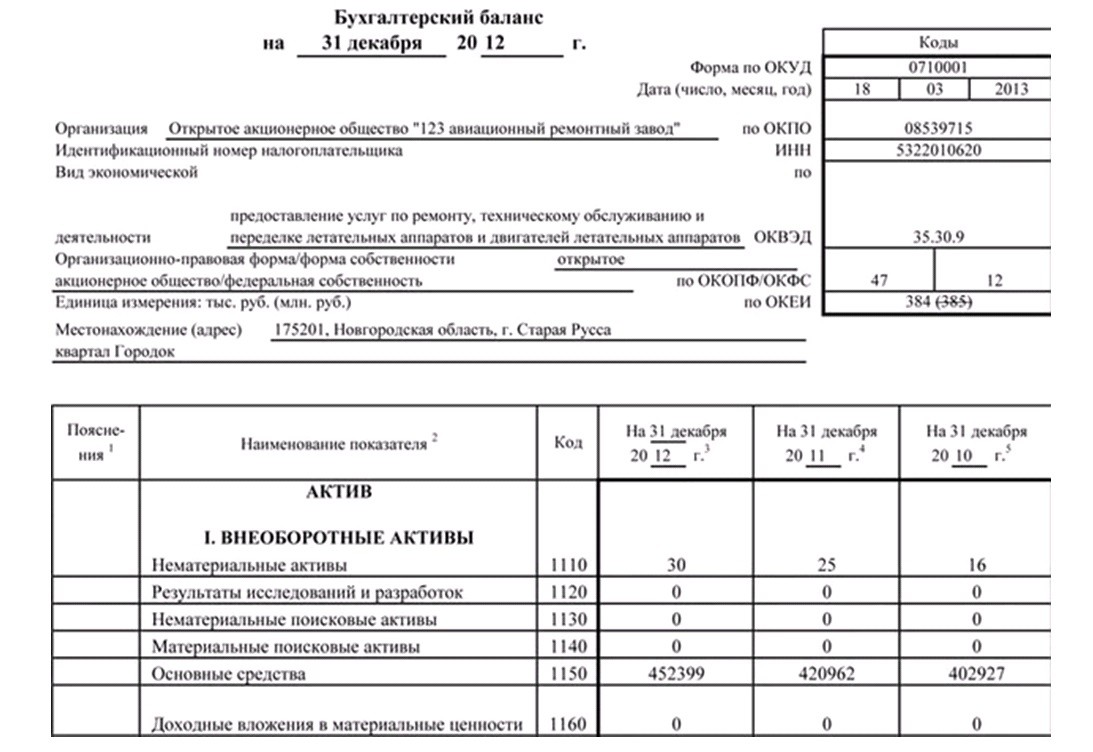

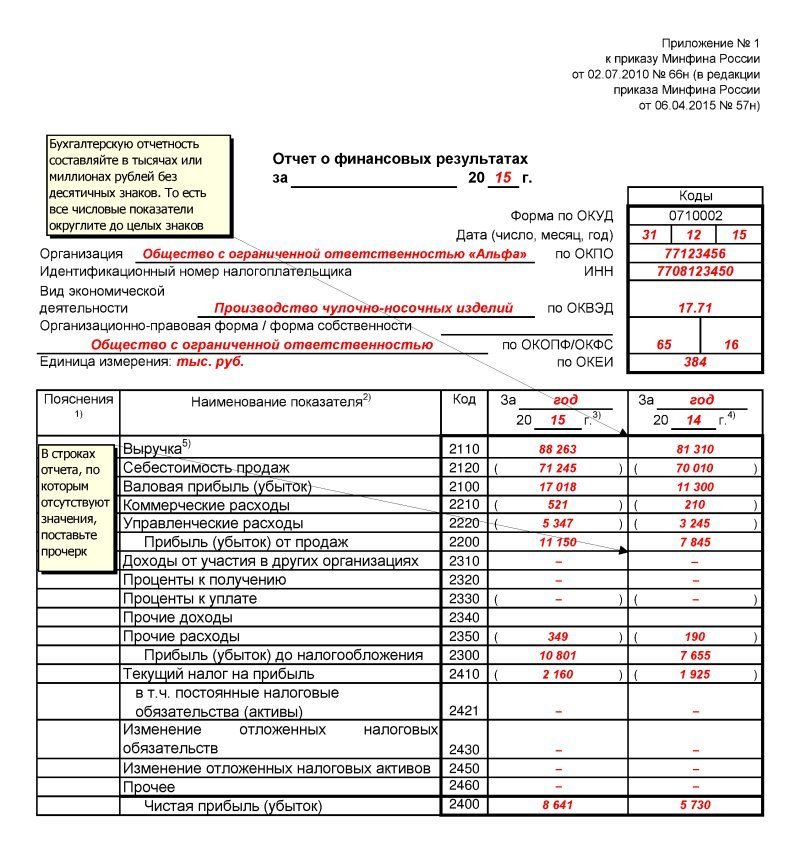

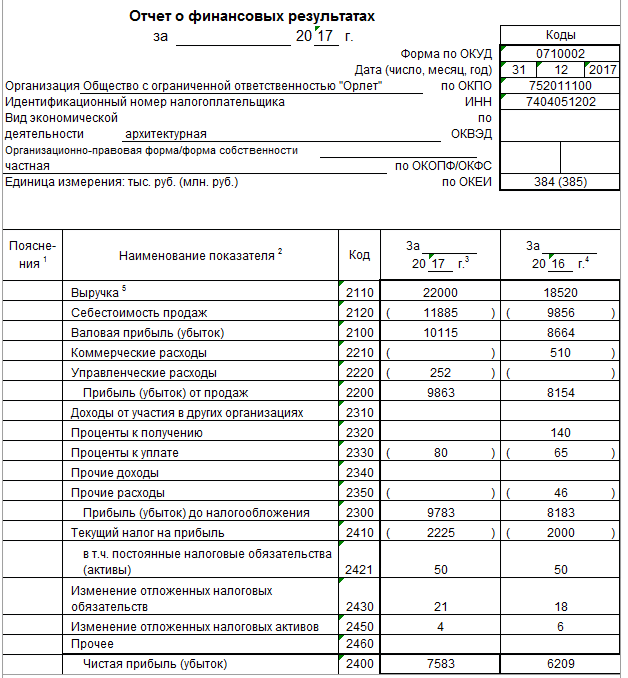

Упрощенцы в силу ограничений по количеству работников и доходам относятся к малым предприятиям, поэтому имеют право использовать сокращенный план счетов и сдавать не полный набор бухотчетности, а только баланс и отчет о финансовых результатах, причем тоже в упрощенной форме. Это право, а не обязанность, и организации могут выбрать вариант, который им удобен.

Если будет решено воспользоваться привилегиями, нужно закрепить план счетов и форму отчетов в Учетной политике.

Формы упрощенных отчетов можно найти в приложении 5 к Приказу Минфина № 66н от 02.07.2010г.

Все ООО до 31 марта отправляют бухотчетность не только в налоговую инспекцию, но и в Росстат.

Другие формы статистического наблюдения предприятия и ИП сдают в том случае, если попадут в ежегодную выборку Росстата.

Если это произойдет, из органов статистики придет уведомление по почте. Там будет указано, какой именно отчет нужно сдать и когда.

Есть еще один способ узнать это: посмотреть списки на сайте регионального отделения Росстата или сформировать уведомление на сайте http://statreg.gks.ru/.

Последний способ самый удобный – не надо искать списки, а затем себя в списках, нужно просто ввести свои данные и получить информацию.

Статистическую отчетность тоже можно заполнить и сразу отправить в сервисе «Мое дело».

Раздел касается всех организаций и тех индивидуальных предпринимателей, у которых есть наемные сотрудники.

Отчитываться нужно в налоговую инспекцию, Пенсионный Фон и ФСС.

В ИФНС подаются:

— Сведения о среднесписочной численности до 20 января.

— Расчет по страховым взносам до 30 апреля, июля, октября и января.

— 6-НДФЛ до 30 апреля, 31 июля, 31 октября и 1 апреля за год.

— 2-НДФЛ на каждого наемного сотрудника до 1 апреля.

В ПФР:

— Сведения о застрахованных лицах по форме СЗВ-М до 15 числа ежемесячно;

— Информация о стаже по форме СЗВ-стаж и ОДВ-1 до 1 марта по истечении года.

В ФСС отправляется только один отчет 4-ФСС в течение 20 дней после каждого квартала или 25 дней, если отчет сдается в электронной форме.

Задач немало несмотря на то, что режим называется упрощенным. Все перечисленное в статье – головная боль бухгалтеров, если они есть. Но для небольших предприятий, и уж тем более ИП держать в штате бухгалтеров – непосильная нагрузка, а порой и нецелесообразные траты. Хорошему бухгалтеру нужно платить много, а плохой может обойтись еще дороже, если наделает ошибок.

Оптимальный вариант – вести бухгалтерию в сервисе «Мое дело». Даже если есть бухгалтер, его работа «в паре» с интернет-бухгалтерий будет быстрее и эффективнее.

Вы заносите свои данные, а система подставляет их куда следует. Не нужно искать актуальные бланки, правила заполнения отчетов, изучать формулы для расчета налогов и самим подсчитывать что и куда вы должны. Все делается в автоматическом режиме.

Заполненные отчеты можно будет скачать, распечатать, или сразу отправить в нужную инстанцию в электронной форме прямо из личного кабинета. Электронную подпись для своих пользователей мы делаем бесплатно.

Статус отправленного отчета также отслеживается в личном кабинете. Если у налоговой имеются к нему нарекания – вы узнаете об этом вовремя и успеете исправить ситуацию до того, как начнутся штрафы.

Сервис интегрирован с банками, поэтому рассчитанные налоги можно сразу оплатить.

Еще одно преимущество наших клиентов – возможность получать бесплатные консультации экспертов в любое время дня и ночи.

А теперь загляните в раздел «Тарифы» и удивитесь, как мало нужно заплатить за все эти возможности.

А чтобы попробовать, даже и платить не нужно – просто зарегистрируйтесь и воспользуйтесь бесплатной демо-версией.

Узнать подробнее про:

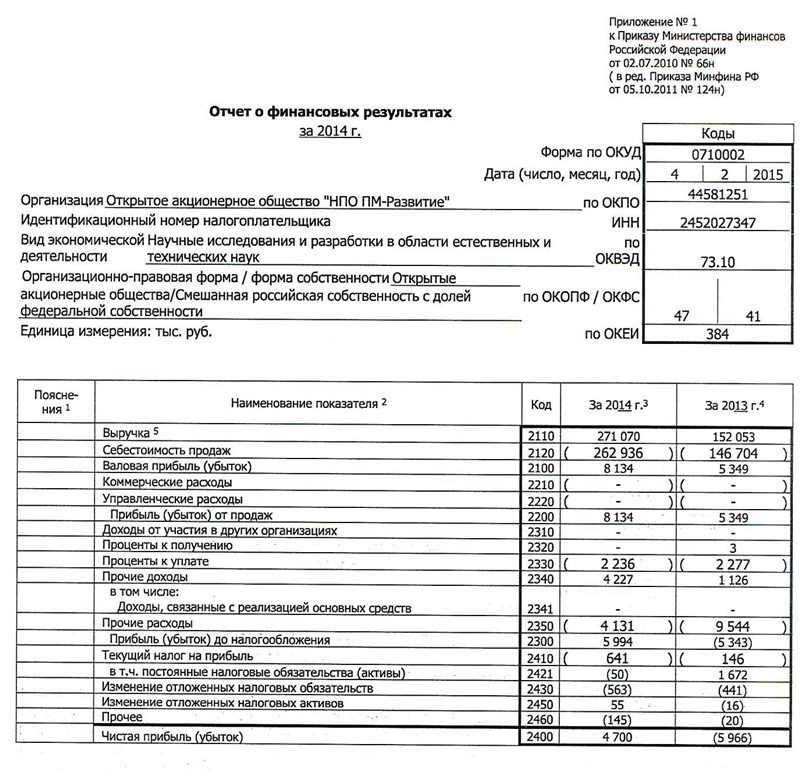

3 важных отчета для бизнеса. Организация и ведение финансового бухгалтерского учета

Финансы в бизнесе — это не пустые цифры в Excel, а данные, на основании которых предприниматель принимает решения. Чтобы понять, успешен ли бизнес, сколько реальной прибыли он приносит, почему появляется кассовый разрыв и как исправить положение в случае убытка, важно разобраться, как правильно вести финансовый учет. В этом помогут три главных отчета. Фактически, финансовый учет и есть совокупность этих отчетов: отчет о движении денежных средств (ДДС), отчет о прибылях и убытках (ПиУ) и отчет по балансу. В этой статье мы разберем, как вести финансовый учет в бизнесе эффективно и с минимальными временными затратами.

В этой статье мы разберем, как вести финансовый учет в бизнесе эффективно и с минимальными временными затратами.

Содержание:

Расскажем, как вести финансовый учет в бизнесе, а также возьмем на себя кадровые и бухгалтерские вопросы. Вы сможете заняться развитием бизнеса, ни о чем не беспокоясь!

1. Отчет о движении денег (ДДС)

Показывает, количество поступивших и ушедших денег на расчетных счетах.

Помогает предсказать кассовый разрыв: критическую точку, когда вам не хватит денег на оплату аренды, покупку товара или выплату зарплаты сотрудникам.

Отчет о движении денежных средств показывает:

-

С какой суммой на счету фирма начала месяц.

-

Сколько получили и потратили в течении месяца.

-

Сколько осталось в конце.

Остаток — это переходящее сальдо.

Важно, чтобы в отчете отражались все счета: расчетные счета в банке, электронные кошельки, наличная касса, сейф, а также фиксировались все расходы по трём направлениям деятельности:

-

операционная: покупка и продажа товаров, зарплаты сотрудников, аренда офиса, лизинг авто;

-

инвестиционная: покупка и продажа оборудования или автомобилей доставки, разработка интернет-магазина;

-

финансовая: кредиты и выплата дивидендов.

Дополнительно можно разбить каждое направление на статьи расходов. Это позволит более детально отслеживать, куда компания тратит деньги.

Не обязательно дробить слишком подробно, можно объединить по категориям. Например, канцелярия, вода, чай и кофе в офис могут быть списаны «на нужды офиса», а топливо, техобслуживание автомобилей и мелкий ремонт — на «транспорт».

Частоту, с которой необходимо сверять отчет и реальное положение дел, каждый предприниматель определяет для себя сам. Можно делать это в конце каждого рабочего дня, можно раз в неделю или месяц.

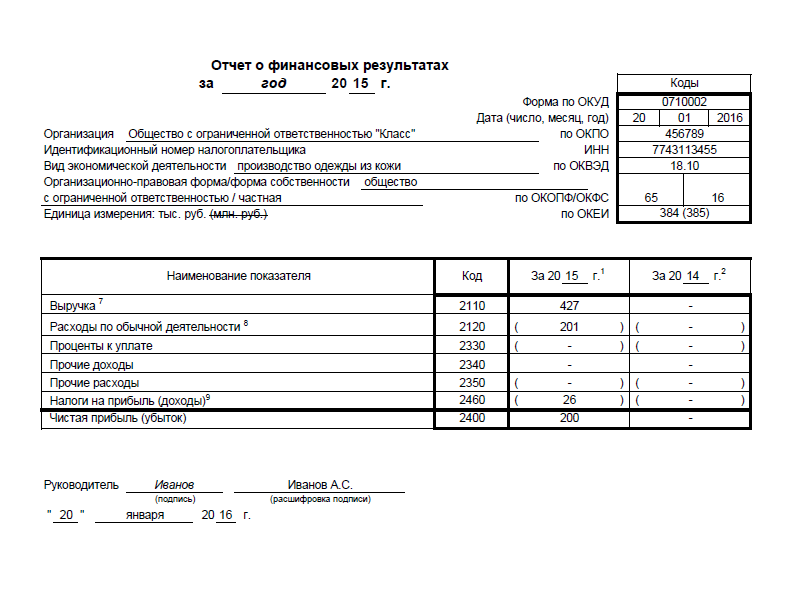

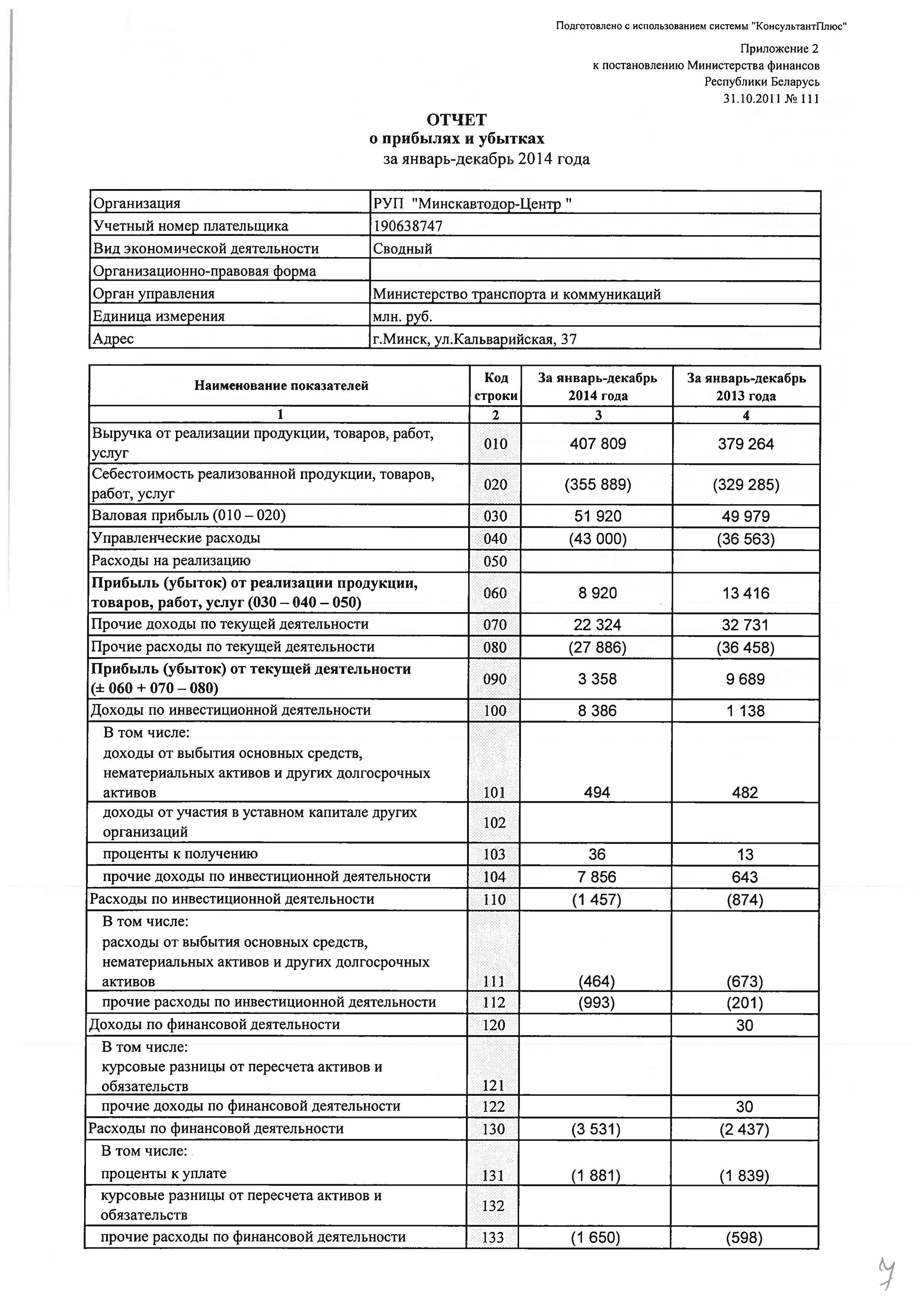

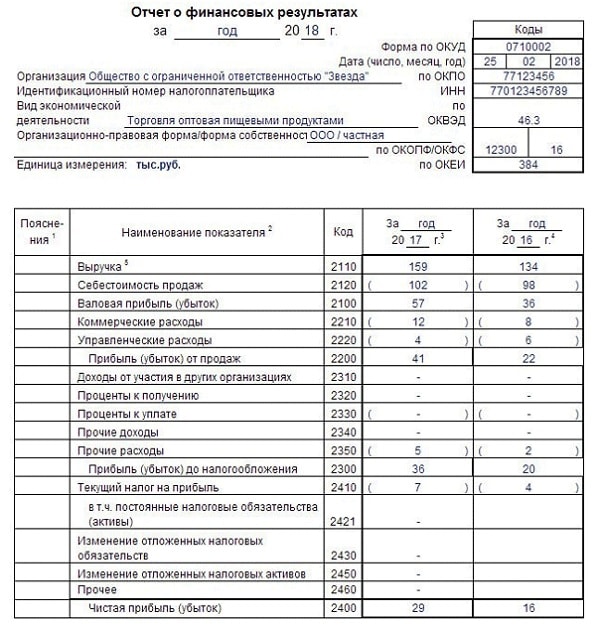

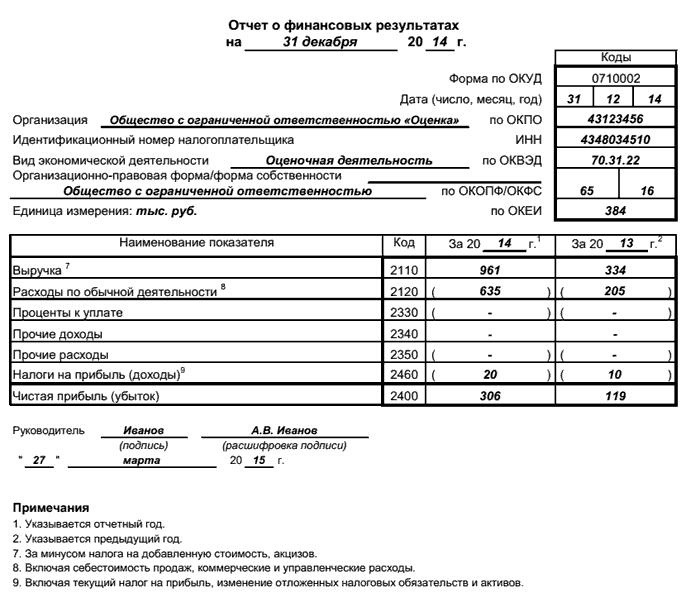

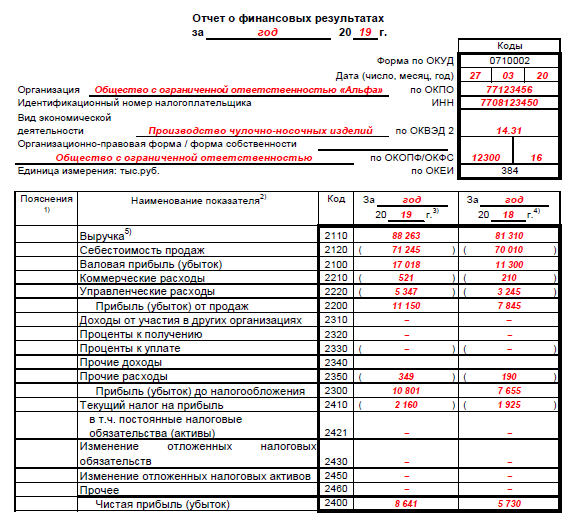

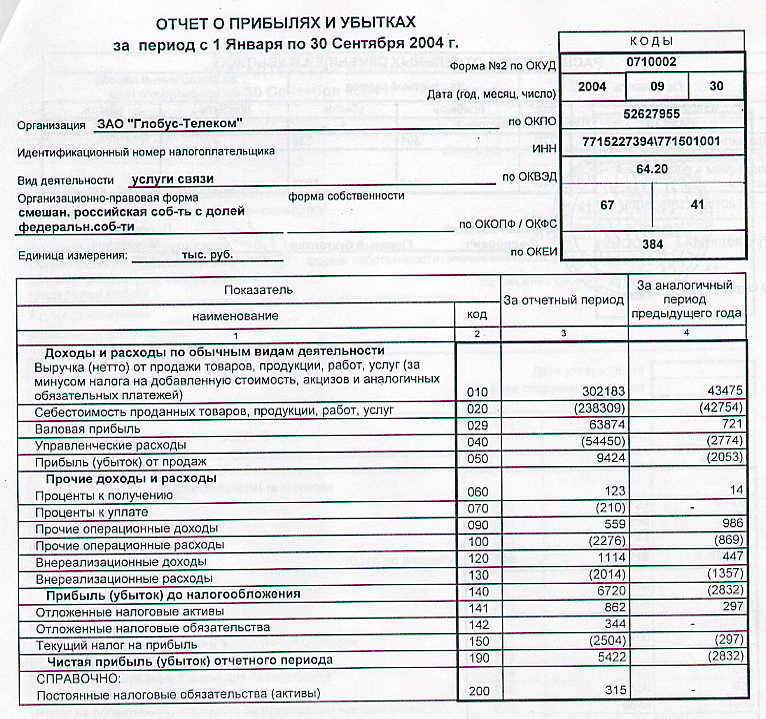

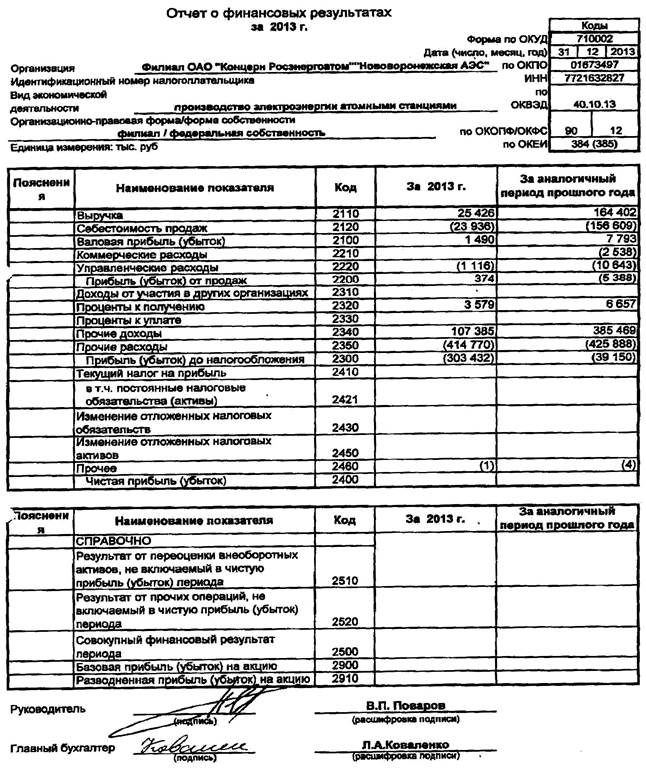

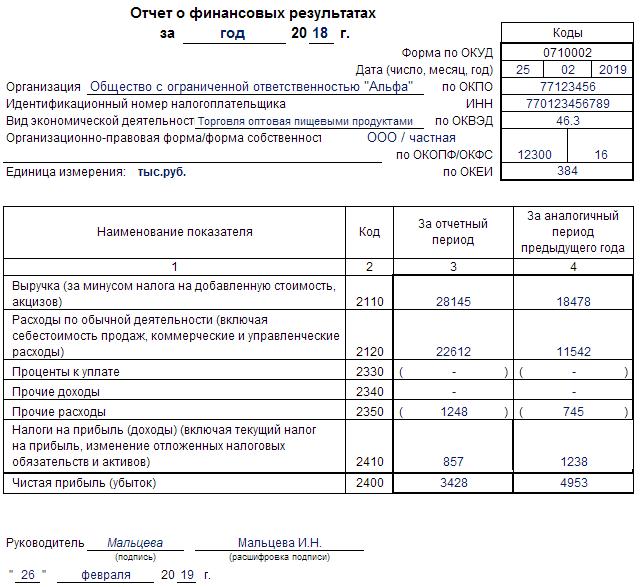

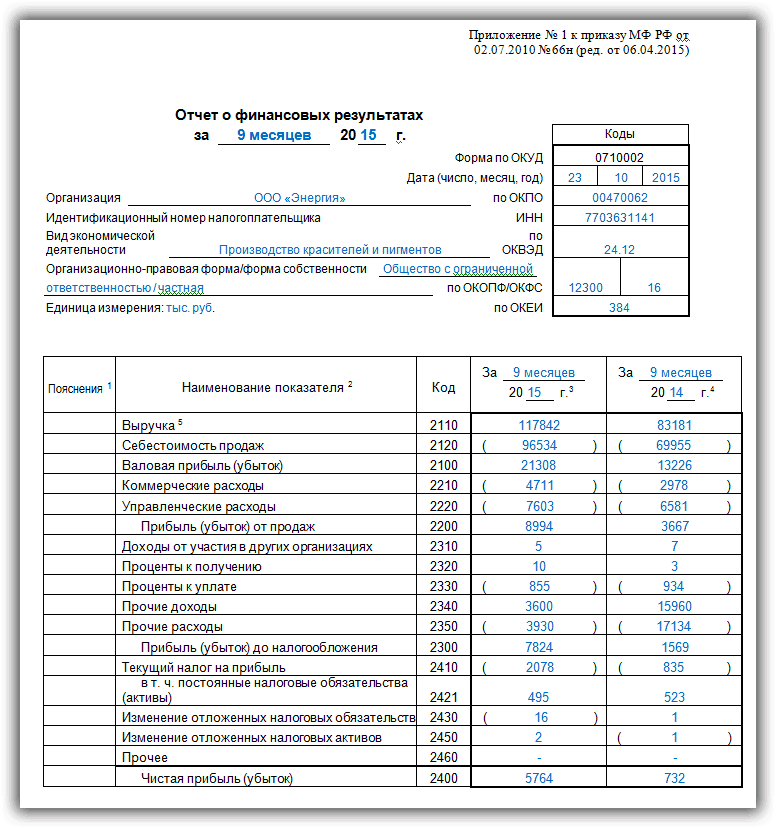

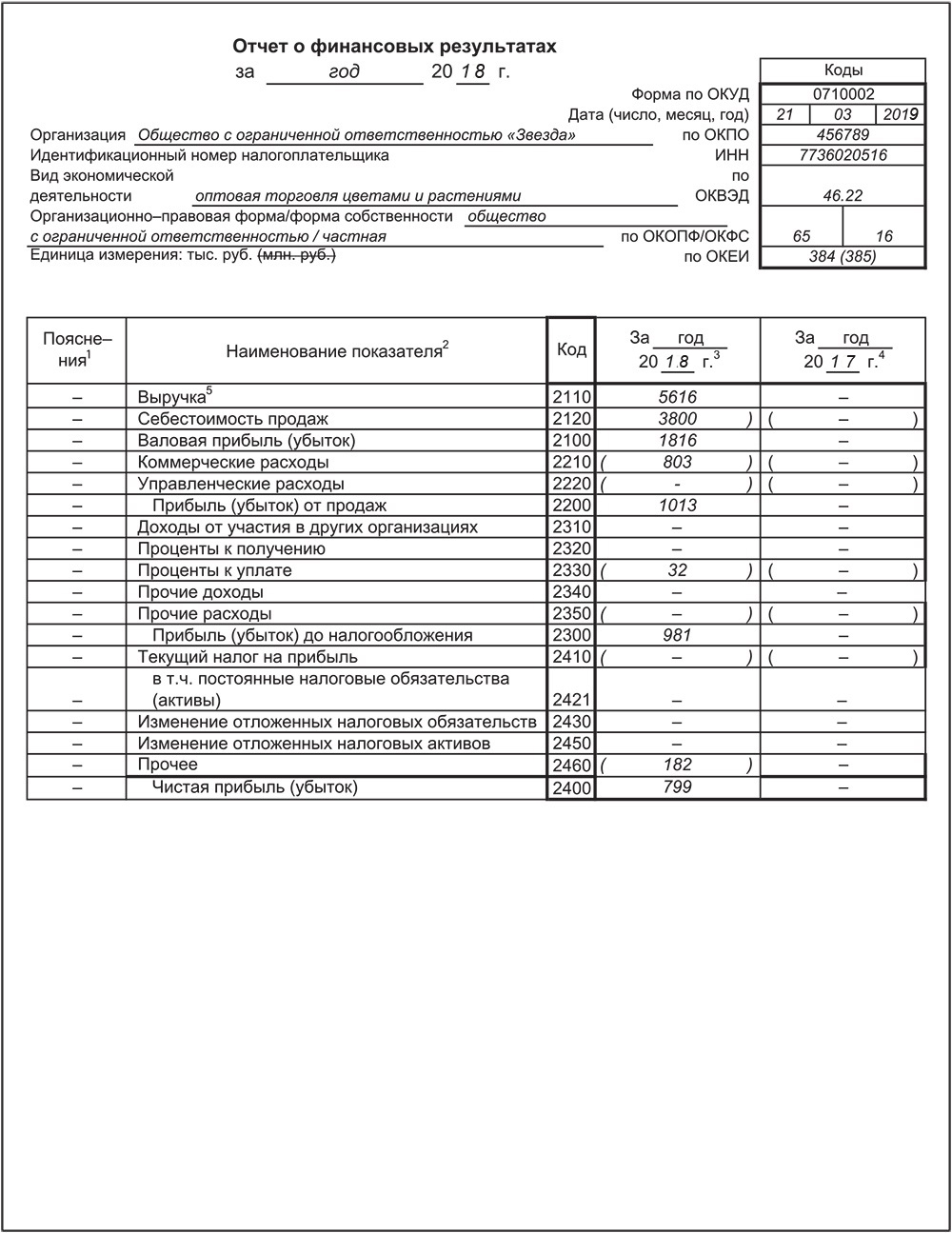

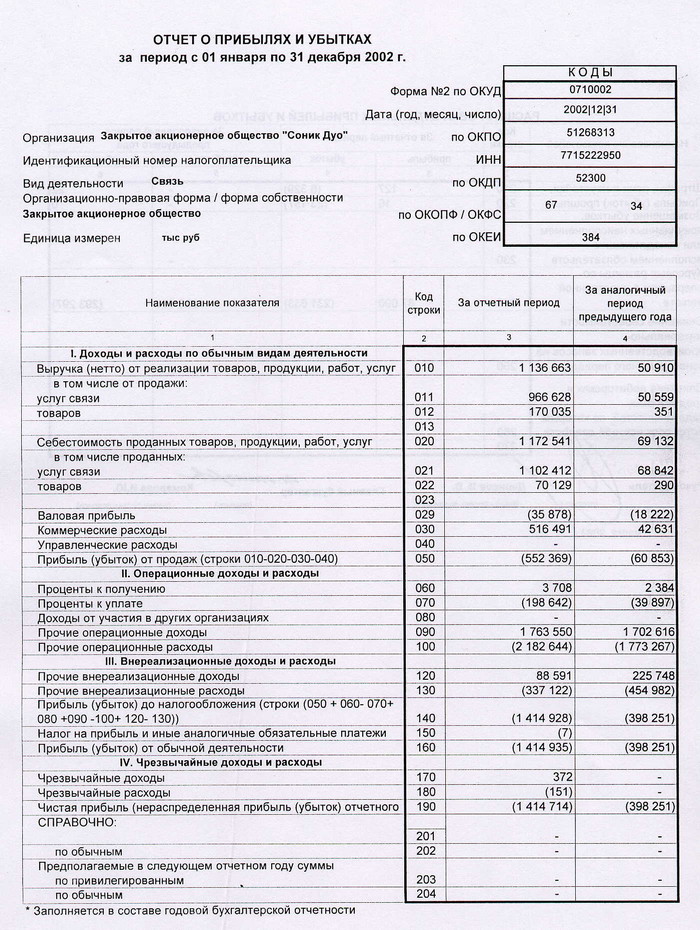

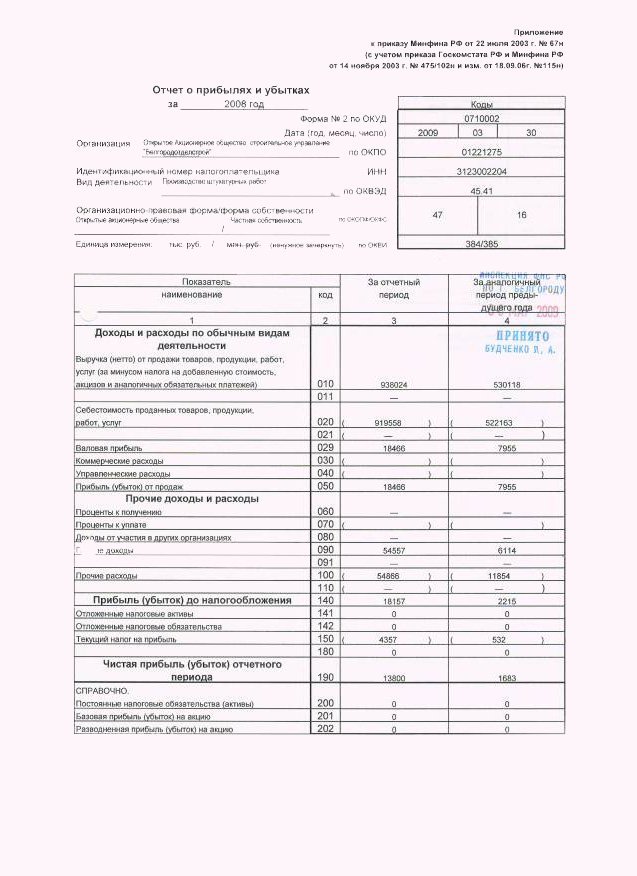

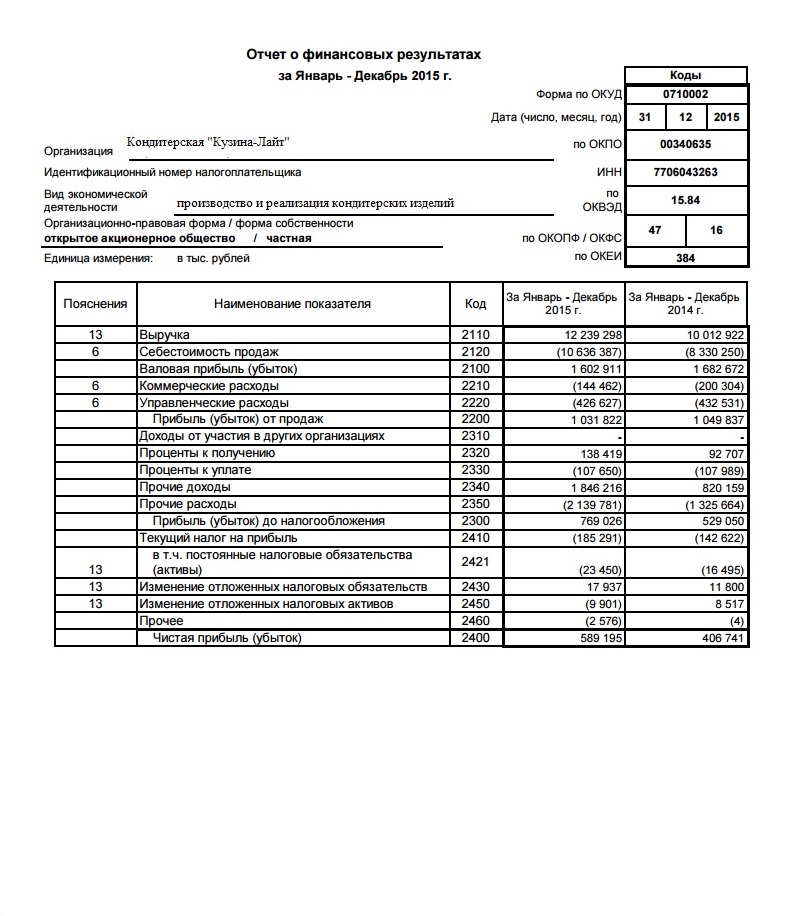

2. Отчет о прибылях и убытках предприятия (ПиУ)

Отчет о прибылях и убытках предприятия показывает результат деятельности компании за отчетный период. Он содержит данные о выручке и расходах бизнеса, которые основываются на закрывающих документах. Анализ отчета о прибылях и убытках помогает оценить чистую прибыль: доход – расход. Формула простая, но большинство бизнесменов считает прибыль неправильно.

Рассмотрим пример.

У Егора бизнес по производству крафтовой упаковки — пик продаж приходится на праздники, когда люди массово покупают и упаковывают подарки. Дела идут хорошо, заказов много, деньги на счете есть. Но когда приходит время платить зарплату и закупать новую бумагу для производства, хватает только на оплату аренды. Регулярно приходится брать в долг, покупать материалы в рассрочку. Основные деньги на счетах — кредитные деньги. Егор составил отчет о прибылях и убытках предприятия и понял, что сумма на счету не является прибылью. Он уже полгода работает в минус, нужно менять финмодель или закрывать компанию.

Регулярно приходится брать в долг, покупать материалы в рассрочку. Основные деньги на счетах — кредитные деньги. Егор составил отчет о прибылях и убытках предприятия и понял, что сумма на счету не является прибылью. Он уже полгода работает в минус, нужно менять финмодель или закрывать компанию.

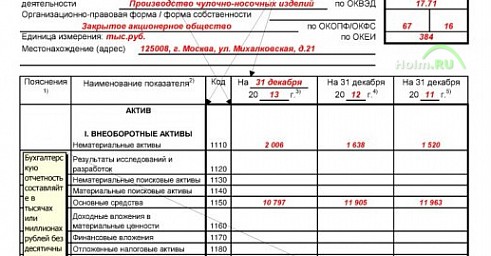

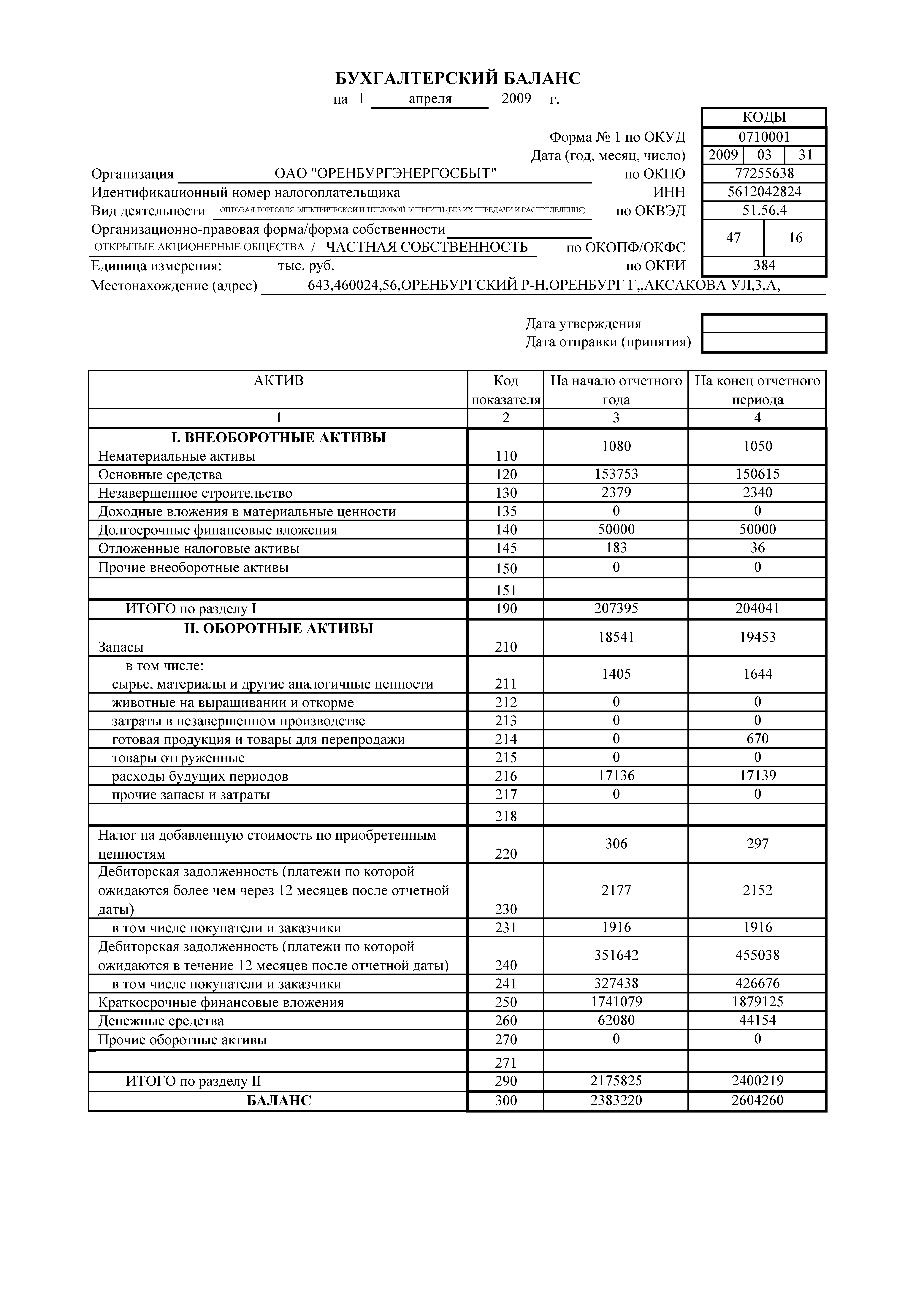

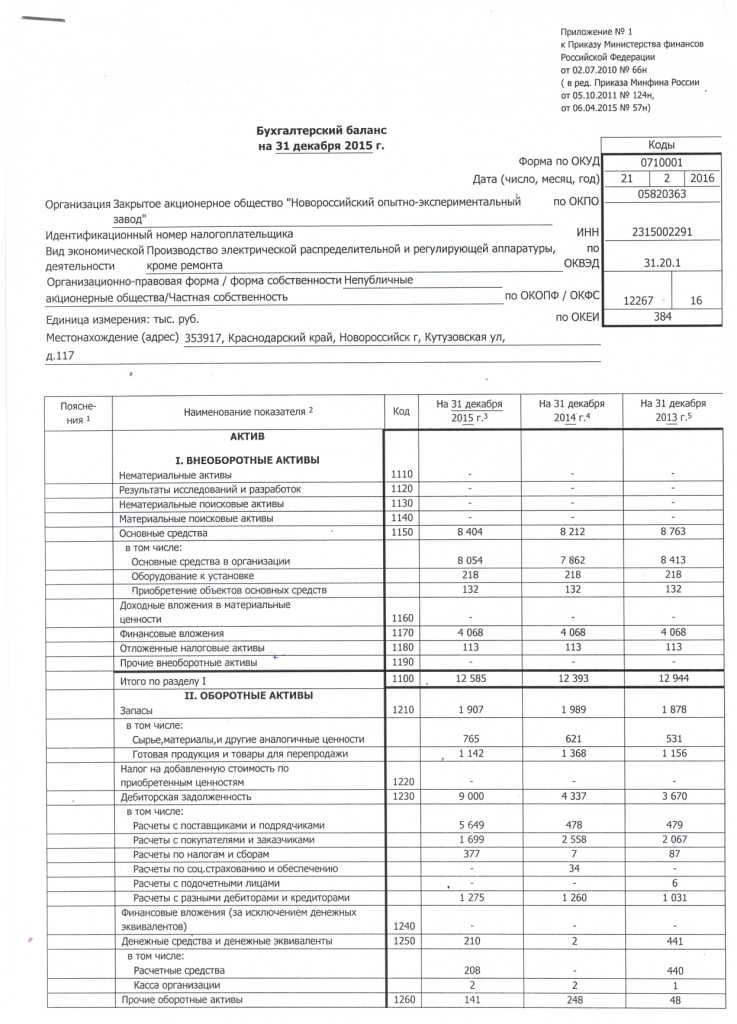

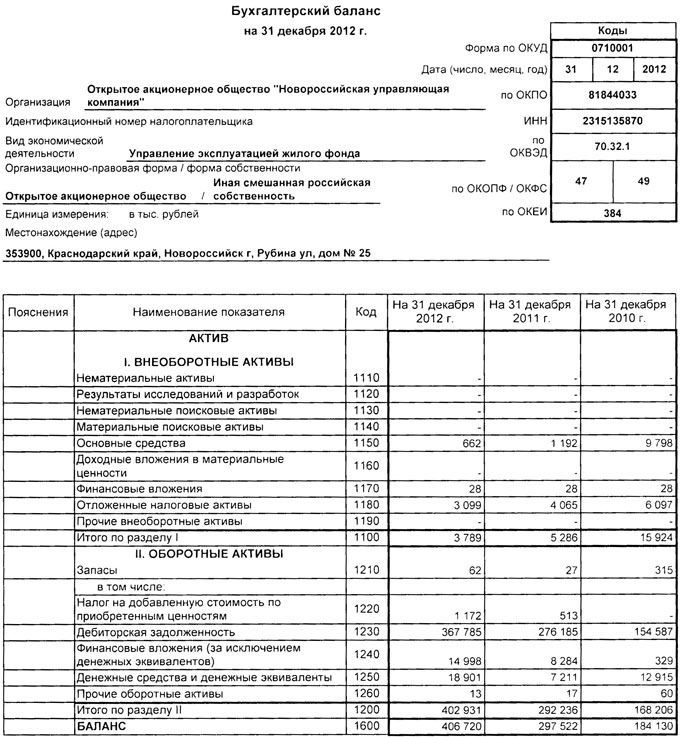

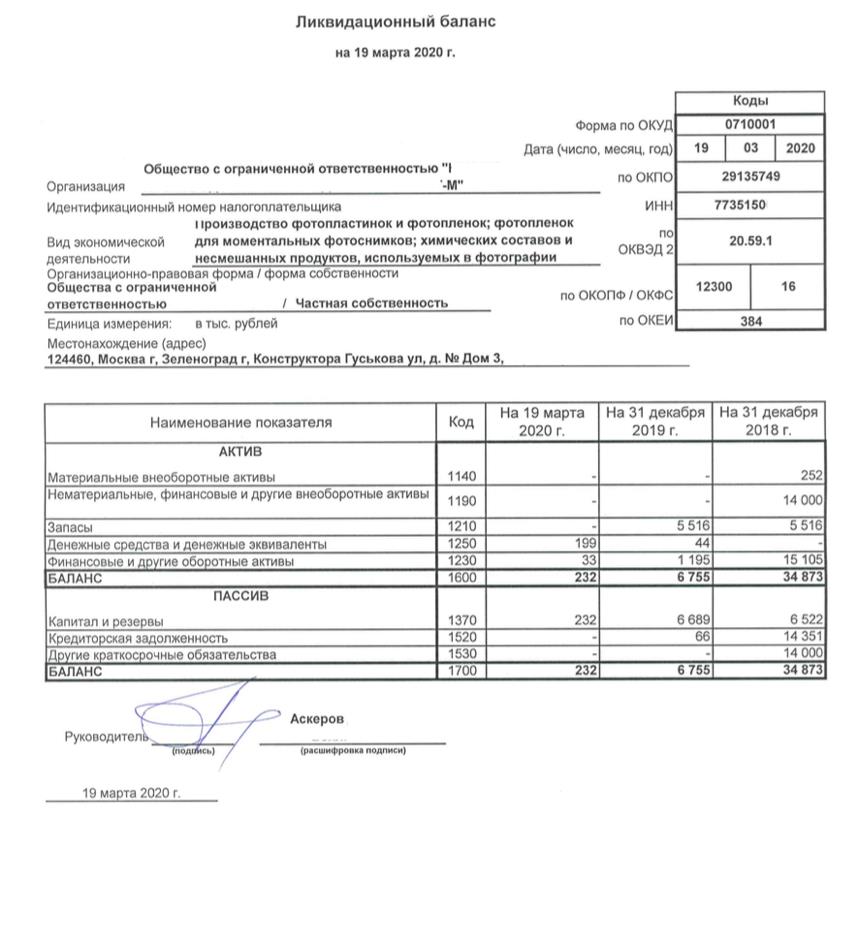

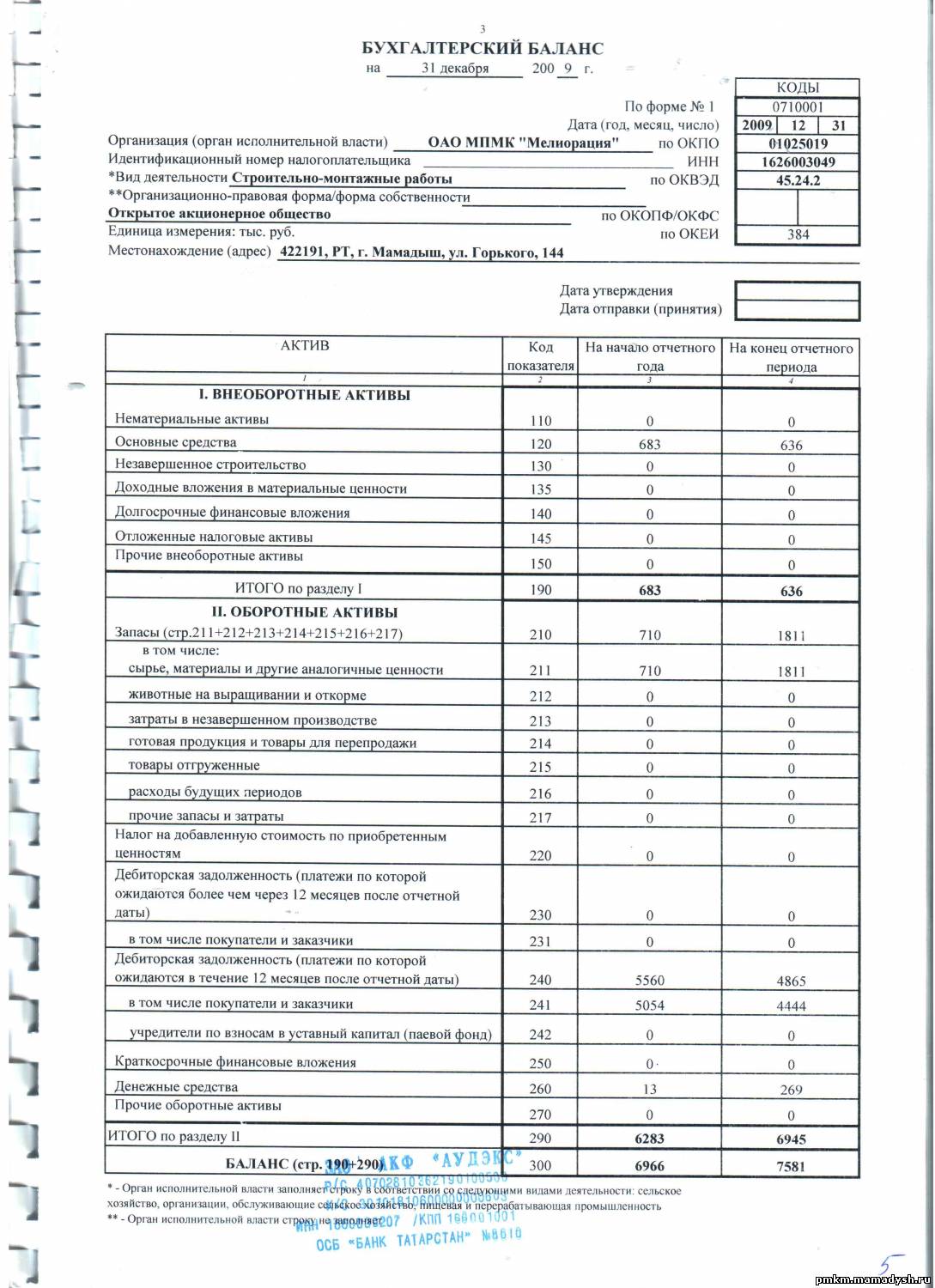

3. Баланс

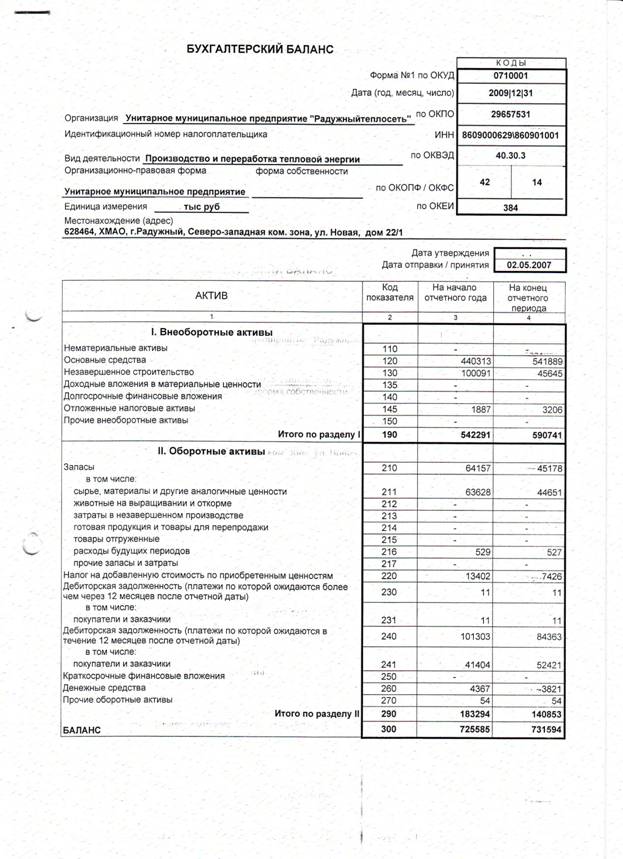

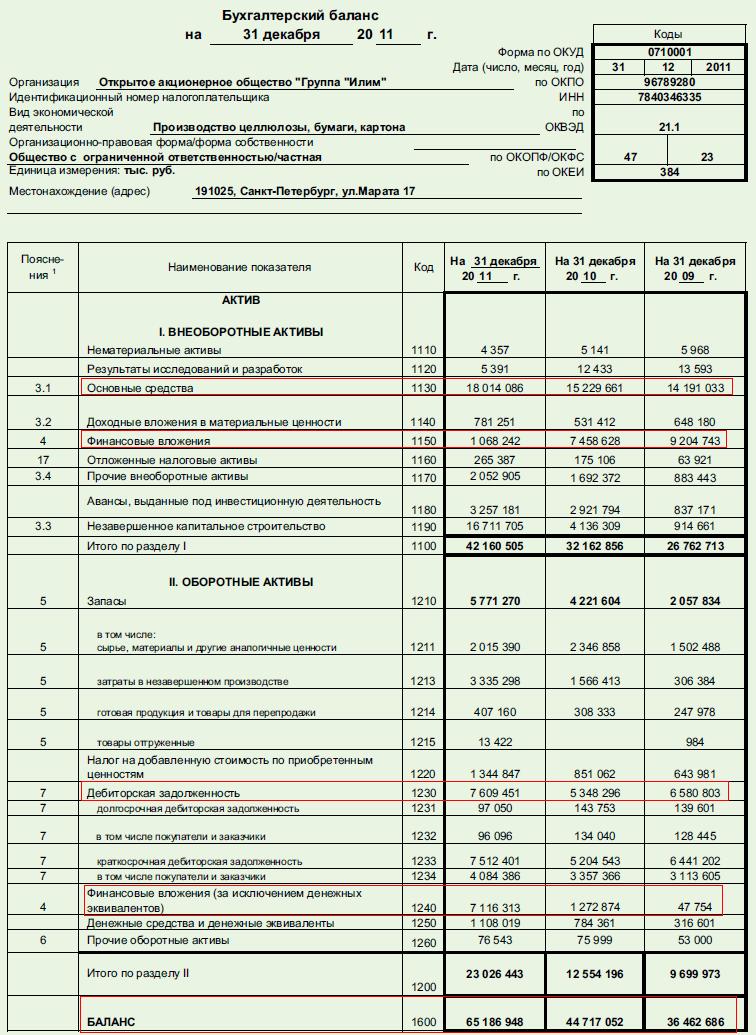

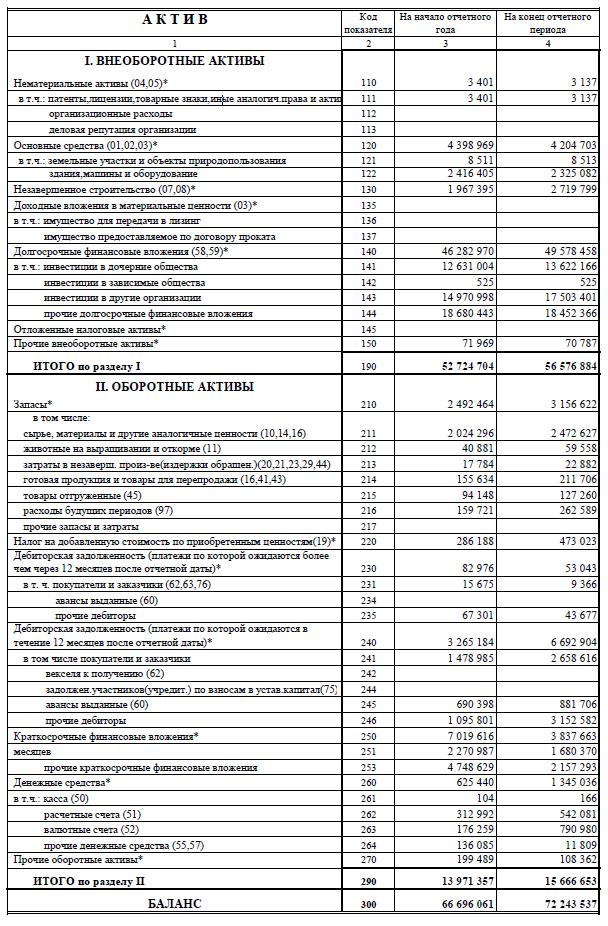

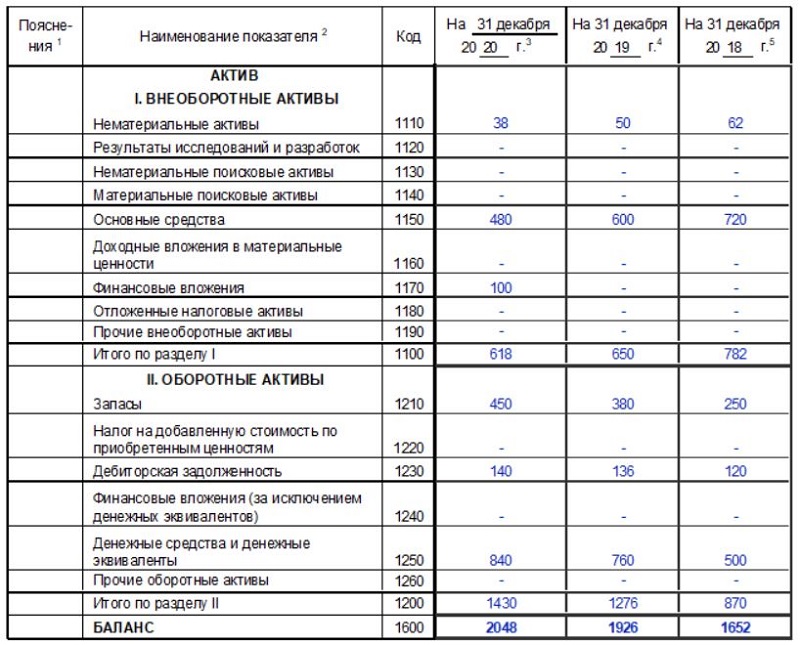

Анализ балансового отчета помогает оценить чистую стоимость капитала, понять, становится ли бизнес прибыльнее и из чего состоит прибыль. Балансовый отчет состоит из активов и пассивов компании. Активы — все имущество, которое находится в компании и обеспечивает ее работу: техника, мебель, служебный автомобиль, оборудование для производства и даже дебиторская задолженность. Нематериальные активы — ценность бренда, товарный знак, патент. Ценность всех активов в способности генерировать прибыль. Пассивы — это средства, на которые куплены активы: личные средства собственника, накопленная прибыль или кредитные деньги.

Балансовый отчет на конец года может отличаться от других периодов. Например, Антон ведет бизнес по продаже подарков на Пасху и Рождество. Минимальный запас материалов на производство придется на март и ноябрь, так как всю продукцию заберут оптовики и розничные магазины для начала продаж. На балансе предприятия в активах будет минус, а в пиковый сезон подготовки к отгрузке товаров, напротив, большой запас.

Например, Антон ведет бизнес по продаже подарков на Пасху и Рождество. Минимальный запас материалов на производство придется на март и ноябрь, так как всю продукцию заберут оптовики и розничные магазины для начала продаж. На балансе предприятия в активах будет минус, а в пиковый сезон подготовки к отгрузке товаров, напротив, большой запас.

Как вести финансовый учёт просто, затрачивая минимум времени?

Не спешите гуглить, чтобы узнать, как вести финансовый учет в Excel. Для этой цели есть более подходящие сервисы!

Отчет о движении денежных средств и отчет о прибылях и убытках предприятия — столпы управленческого учета. Оба отчета просто и удобно готовить в сервисе Seeneco, чтобы не ломать голову над тем, как вести финансовый учет в Excel.

Отчет о движении денежных средств формируется на основе фактических выплат и поступлений по всем счетам и кассам бизнеса и показывает остатки денег на начало и конец периода, денежные потоки по операционной, финансовой и инвестиционной деятельности.

Отчет о прибылях и убытках предприятия формируется на основе доходов и расходов, показывает прибыль в разрезе денежных потоков: по месяцам, по кварталу и году.

В Seeneco любую ячейку каждого отчета можно раскрыть: увидеть, какие операции составили ее результат, как деньги распределились по контрагентам.

Отчет можно скачать в Excel, чтобы продолжить работу в привычном инструменте, показать инвесторам или кредиторам.

Теперь вы знаете, как вести финансовый учет в бизнесе и понимаете, зачем составлять отчет о прибылях и убытках предприятия, отчет о движении денежных средств и отчет по балансу. Эти знания помогут предотвратить кассовый разрыв и минимизировать потери, если он все же наступил. О том, как вести финансовый учет в Excel, забудьте — есть более удобные современные сервисы для этих целей.

С пониманием того, как правильно вести финансовый учет, вы убережете свой бизнес от многих проблем. Отслеживайте ключевые показатели и будьте успешны!

Отслеживайте ключевые показатели и будьте успешны!

Финансовая отчетность | ООО «СМАРТ Партнер»

ООО «СМАРТ Партнер» согласно Инструкции об объеме и порядке раскрытия информации о лизинговой деятельности и финансовом состоянии лизинговых организаций, включенных в реестр лизинговых организаций, утвержденной Постановлением Правления Национального банка Республики Беларусь от 01.08.2014г. №495 представляет следующую информацию:

ООО «СМАРТ Партнер» зарегистрировано Минским городским исполнительным комитетом 05 октября 2012 года в Едином государственном регистре юридических лиц и индивидуальных предпринимателей за № 191766663. ООО «СМАРТ Партнер» 16 сентября 2014 года включен в реестр лизинговых организаций с присвоением идентификационного кода 10007.Уставный фонд ООО «СМАРТ Партнер» сформирован в размере 93000 BYN.

Свидетельство о включении в реестр лизинговых организаций — Смотреть.

Свидетельство о государственной регистрации — Смотреть.

Устав ООО «СМАРТ Партнер» — Смотреть.

Годовая финансовая отчетность ООО «СМАРТ Партнер»:

За 2013 год:

За 2014 год:

За 2015 год:

За 2016 год:

За 2017 год:

За 2018 год:

За 2019 год:

За 2020 год:

За 2021 год:

Декларация о присоединении к кодексу добросовестного поведения и профессиональной этики лизинговых организаций Республики Беларусь

Смотреть.

Уведомление о смене юридического адреса

Смотреть.

Изменение реквизитов

Смотреть.

Уведомление о смене главного бухгалтера.

С 08 января 2019 года Индивидуальный предприниматель Шуста Елена Александровна, действующая на основании Свидетельства о государственной регистрации 0156124 от 10. 07.2008г оказывает бухгалтерские услуги и ведет бухгалтерский учет ООО «СМАРТПартнер».

07.2008г оказывает бухгалтерские услуги и ведет бухгалтерский учет ООО «СМАРТПартнер».

Смотреть свидетельство.

Юридическим лицам и индивидуальным предпринимателям ООО «СМАРТ Партнер» предоставляет услуги финансового лизинга.

Договор финансового лизинга – это соглашение между лизингодателем и лизингополучателем об установлении прав и обязанностей по поводу приобретения лизингодателем в собственность указанного лизингополучателем предмета лизинга у определенного последним продавца (поставщика) и предоставления лизингополучателю объекта лизинга за плату во временное владение и пользование с правом или без права выкупа либо предоставления лизингодателем лизингополучателю ранее приобретенного предмета лизинга за плату во временное владение и пользование с правом или без права выкупа.

ООО «СМАРТ Партнер» оказывает следующие услуги:

- Финансовый лизинг

- Лизинг автомобилей;

- Лизинг строительной техники;

- Лизинг оборудования;

- Лизинг недвижимости;

- Валютный лизинг — возможность приобретения предмета лизинга за границей и заключение внешнеэкономических контрактов;

- Микролизинг – лизинг офисной мебели,компьютеров, ноутбуков, принтеров, сотовых телефонов, любой другой оргтехники и т.

д.

д.

Порядок осуществления расчетов:

- расчеты производятся платежными поручениями в безналичном порядке на расчетный счет ООО «СМАРТ Партнер»;

- по соглашению сторон, расчеты могут быть произведены в иных не запрещенных законодательством РБ формах;

- уплата лизинговых платежей производится в белорусских рублях и в иностранной валюте, если использование иностранной валюты для проведения расчетов по договору лизинга разрешено законодательством.

Условия проведения сделок:

- Авансовый платеж: от 20% до 40%.

- Срок лизинга: от 1 до 4-х лет.

- Лизинговые платежи осуществляются ежемесячно. В состав лизингового платежа входит возмещение стоимости предмета лизинга и вознаграждение (доход) лизингодателя.

- Размер выкупной стоимости предмета лизинга определяется по соглашению сторон и может составлять от 10% до 1% от стоимости предмета лизинга.

- Валюта договора лизинга: в белорусских рублях, долларах США (евро) с оплатой в белорусских рублях по курсу НБ РБ.

- Договор купли-продажи предмета лизинга заключается лизингодателем.

- В рамках реализации договора лизинга лизингодателем и/или лизингополучателем могут при необходимости заключаться договора добровольного страхования предмета лизинга, договора поручительства. С целью финансирования договора лизинга лизингодателем могут привлекаться кредитные (заемные) ресурсы, что предполагает заключение кредитного договора (договора займа), договоров залога, поручительства (при необходимости).

*Данные условия не являются публичной офертой и могут изменяться. Окончательные условия устанавливаются в договоре лизинга

Порядок и условия определения вознаграждения (дохода) за осуществление лизинговой сделки:

Размер вознаграждения (дохода) ООО «СМАРТ Партнер» определяется по соглашению сторон Договора лизинга в виде денежной суммы и указывается в Графике лизинговых платежей, который является отдельным приложением и неотъемлемой частью Договора лизинга. Вознаграждение (доход) входит в состав лизинговых платежей.

Вознаграждение (доход) входит в состав лизинговых платежей.

Лизинговая компания ООО «СМАРТ Партнер» предлагает юридическим лицам и индивидуальным предпринимателям заключить договор лизинга, в который входит ГИБКИЙ ГРАФИК лизинговых платежей. Каждый клиент для нас индивидуален.

Мы УЧИТЫВАЕМ СЕЗОННОСТЬ вашего бизнеса в течение календарного года и делаем размер лизинговых платежей удобным и соразмерными вашим ежемесячным приходам. ООО «СМАРТ Партнер» для всех клиентов без исключения предлагает возможность БЕСПЛАТНОГО ДОСРОЧНОГО ПОГАШЕНИЯ лизинговых платежей с пересчетом лизинговой ставки.

Заявку на услуги лизинговой компании «СМАРТ Партнер» можно заполнить на сайте www.smartpartner.by либо связаться с нами по телефонам:

- +375 29 190-96-79 Velcom

- +375 17 326-96-79

Мы находимся по адресу: г. Минск, ул. Некрасова 7, к. 219

Время работы:

Понедельник-пятница: 9. 30-17.00

30-17.00

суббота-воскресенье: Выходной

Бухгалтерская отчетность по РСБУ — ПАО «Транснефть»

Бухгалтерская отчетность по РСБУ, опубликованная в соответствии с требованиями законодательства о раскрытии информации на рынке ценных бумаг.

2021

Промежуточная бухгалтерская отчетность на 30.09.2021

2020

Аудиторское заключение по бухгалтерской отчетности ПАО «Транснефть» за 2020 год

Бухгалтерский баланс на 31 декабря 2020 года

Отчет о финансовых результатах за 2020 год

Отчет об изменениях капитала за 2020 год

Отчет о движении денежных средств за 2020 год

Пояснения к бухгалтерскому балансу и отчету о финансовых результатах ПАО «Транснефть» за 2020 год

Промежуточная бухгалтерская отчетность на 30.09.2020

Промежуточная бухгалтерская отчетность на 30.06.2020

Промежуточная бухгалтерская отчетность на 31.03.2020

2019

Аудиторское заключение по бухгалтерской отчетности ПАО «Транснефть» за 2019 год

Бухгалтерский баланс на 31 декабря 2019 года

Отчет о финансовых результатах за 2019 год

Отчет об изменениях капитала за 2019 год

Отчет о движении денежных средств за 2019 год

Пояснения к бухгалтерскому балансу и отчету о финансовых результатах ПАО «Транснефть» за 2019 год

Промежуточная бухгалтерская отчетность на 30. 09.2019

09.2019

Промежуточная бухгалтерская отчетность на 30.06.2019

Промежуточная бухгалтерская отчетность на 31.03.2019

2018

Аудиторское заключение по бухгалтерской отчетности ПАО «Транснефть» за 2018 год

Бухгалтерский баланс на 31 декабря 2018 года

Отчет о финансовых результатах за 2018 год

Отчет об изменениях капитала за 2018 год

Отчет о движении денежных средств за 2018 год

Пояснения к бухгалтерскому балансу и отчету о финансовых результатах ПАО «Транснефть» за 2018 год

Промежуточная бухгалтерская отчетность на 30.09.2018

Промежуточная бухгалтерская отчетность на 30.06.2018

Промежуточная бухгалтерская отчетность на 31.03.2018

2017

Аудиторское заключение по бухгалтерской отчетности ПАО «Транснефть» за 2017 год

Бухгалтерский баланс на 31 декабря 2017 года

Отчет о финансовых результатах за 2017 год

Отчет об изменениях капитала за 2017 год

Отчет о движении денежных средств за 2017 год

Пояснения к бухгалтерскому балансу и отчету о финансовых результатах ПАО «Транснефть» за 2017 год

Промежуточная бухгалтерская отчетность на 30. 09.2017

09.2017

Промежуточная бухгалтерская отчетность на 30.06.2017

2016

Аудиторское заключение по бухгалтерской отчетности ПАО «Транснефть» за 2016 год

Бухгалтерский баланс на 31 декабря 2016 года

Отчет о финансовых результатах за 2016 год

Отчет об изменениях капитала за 2016 год

Отчет о движении денежных средств за 2016 год

Пояснения к бухгалтерскому балансу и отчету о финансовых результатах ПАО «Транснефть» за 2016 год

2015

Аудиторское заключение по бухгалтерской отчетности ОАО «АК «Транснефть» за 2015 год

Бухгалтерский баланс на 31 декабря 2015 года

Отчет о финансовых результатах за 2015 год

Отчет об изменениях капитала за 2015 год

Отчет о движении денежных средств за 2015 год

Пояснения к бухгалтерскому балансу и отчету о финансовых результатах ОАО «АК «Транснефть» за 2015 год

2014

Аудиторское заключение по бухгалтерской отчетности ОАО «АК «Транснефть» за 2014 год

Бухгалтерский баланс на 31 декабря 2014 года

Отчет о финансовых результатах за 2014 год

Отчет об изменениях капитала за 2014 год

Отчет о движении денежных средств за 2014 год

Пояснения к бухгалтерскому балансу и отчету о финансовых результатах ОАО «АК «Транснефть» за 2014 год

2013

Аудиторское заключение по бухгалтерской отчетности ОАО «АК «Транснефть» за 2013 год

Бухгалтерский баланс на 31 декабря 2013 года

Отчет о финансовых результатах за 2013 год

Отчет об изменениях капитала за 2013 год

Отчет о движении денежных средств за 2013 год

Пояснения к бухгалтерскому балансу и отчету о финансовых результатах ОАО «АК «Транснефть» за 2013 год

2012

Аудиторское заключение по бухгалтерской отчетности ОАО «АК «Транснефть» за 2012 год

Бухгалтерский баланс на 31 декабря 2012 года

Отчет о финансовых результатах за 2012 год

Отчет об изменениях капитала за 2012 год

Отчет о движении денежных средств за 2012 год

Пояснения к бухгалтерскому балансу и отчету о финансовых результатах ОАО «АК «Транснефть» за 2012 год

2011

Аудиторское заключение по бухгалтерской отчетности ОАО «АК «Транснефть» за 2011 год

Бухгалтерский баланс на 31 декабря 2011 года

Отчет о прибылях и убытках за 2011 год

Отчет об изменениях капитала за 2011 год

Отчет о движении денежных средств за 2011 год

Пояснительная записка к годовой бухгалтерской отчетности ОАО «АК «Транснефть» за 2011 год

Расшифровка расчётного счёта: что означают цифры в номере

При открытии расчётного счёта в банке вы получаете комбинацию из цифр, которая по сути является индивидуальным шифром для хранения средств. В целом вам необязательно знать все особенности расшифровки — банки действуют строго в рамках закона, а комбинация из цифр формируется вычислительной системой. Однако знать матчасть все же стоит: ошибка в двух цифрах при отправке платежа на счёт юридического лица может стоить вам времени и денег. Вы также будете больше знать о ваших партнерах по бизнесу, внимательно изучив их расчетный счет.

В целом вам необязательно знать все особенности расшифровки — банки действуют строго в рамках закона, а комбинация из цифр формируется вычислительной системой. Однако знать матчасть все же стоит: ошибка в двух цифрах при отправке платежа на счёт юридического лица может стоить вам времени и денег. Вы также будете больше знать о ваших партнерах по бизнесу, внимательно изучив их расчетный счет.

Структура банковского счёта

Расчётный счёт состоит из 20 цифр, каждая из которых имеет свое значение. Все числа, входящие в номер, разделены на группы, которые отражает определенные характеристики счёта.

Отметим, что счёт физического лица всегда начинается с цифр 408. Эта комбинация едина для всех российских банков. При этом ИП, хоть и являются формально физлицами, их счета начинаются так же, как и юридических: с 407.

Теперь расшифровываем значение счёта, разбив номер на группы: 111.22.333.4.5555.6666666:

111 — счёт первого порядка банковского баланса, по которому можно узнать, кто открыл счёт и с какой целью.

22 — счёт второго порядка, и эти цифры указывают на специфику деятельности владельца счёта.

333 — валюта, в которой хранятся средства на счету.

4 — проверочный код.

5555 — комбинация, означающая отделение банка, в котором открыт счёт.

6666666 — порядковый номер счёта в вашем банке.

Как расшифровать цифры?

Для начала выясним, что означает расшифровка первых пяти цифр в расчётном счёте, которые составляют определенную группу счетов баланса банка. Эти счета утверждены Центробанком и включают два раздела.

Первый состоит из трех цифр и означает специфику расчётов. Например, эти комбинации имеют разную расшифровку:

от 102 до 109 — счета фондов, а также хранение капитала, учёт прибыли и убытков;

203 и 204 — счета для учёта драгметаллов;

с 301 по 329 — счета для проведения операций между банками;

401 и 402 — счета для переводов в бюджет;

403 — управление деньгами, находящимся в ведении Минфина;

404 — внебюджетные фонды;

405 и 406 — счета государственных компаний;

407 — юридические компании и ИП;

408 — физлица;

с 411 по 419 — вклады, открытые государственными структурами;

с 420 по 422 — хранение средств юридических лиц;

423 — вклад открыт физическим лицом-резидентом;

424 — средства иностранных компаний;

425 — средства на вкладе принадлежат физическому лицу-нерезиденту;

430 — средства банков;

с 501 по 526 — счета, необходимые для учета ценных бумаг.

Следующие две цифры в расчётном счёте дополняют три предыдущие и трактуются вместе с ними. Теперь давайте разберем их на примере юридических компаний. Напоминаем, счета юрлиц начинаются с 407.

40701 — организация имеет отношение к финансовому сектору;

40702 — открытые и закрытые общества;

40703 — счета некоммерческих объединений;

40704 — средства, выделенные для проведения выборов или общественных собраний.

Следующие три цирфы счёта означают валюту, в которой открыт счет. А именно:

810 — счет открыт в рублях;

840 — в долларах США;

978 — в евро.

Затем следует проверочная цифра — ключ, который позволяет выяснить, правильно ли обозначен счёт при помощи обработки автоматической системы.

Следующие четыре цифры означают номер отделения, в котором открыт счёт. Если вместо них указаны нули, то банк либо не владеет отделениями, либо же счёт был открыт в головном офисе.

Последние семь цифр — это порядковый регистр счёта в банке. Отметим, что по закону любой банк вправе применять свою классификацию этих цифр.

Напоминаем, что в ДелоБанке вы можете открыть бесплатно расчётный счёт буквально за 10 минут. Просто оставьте свой телефон в заявке и наш оператор свяжется с вами в самое ближайшее время. На счёт можно получать деньги после резервирования, и номер можно указывать в любых документах – он не изменится после активации.

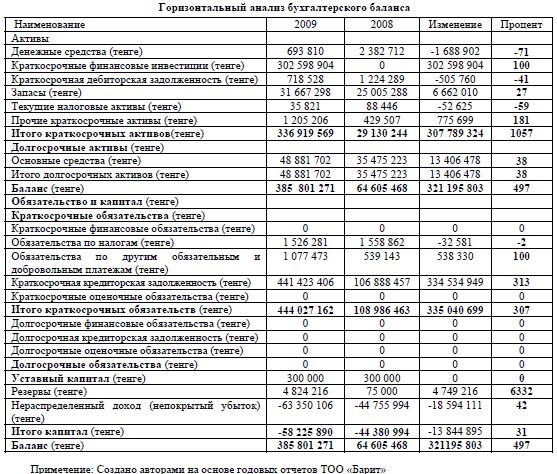

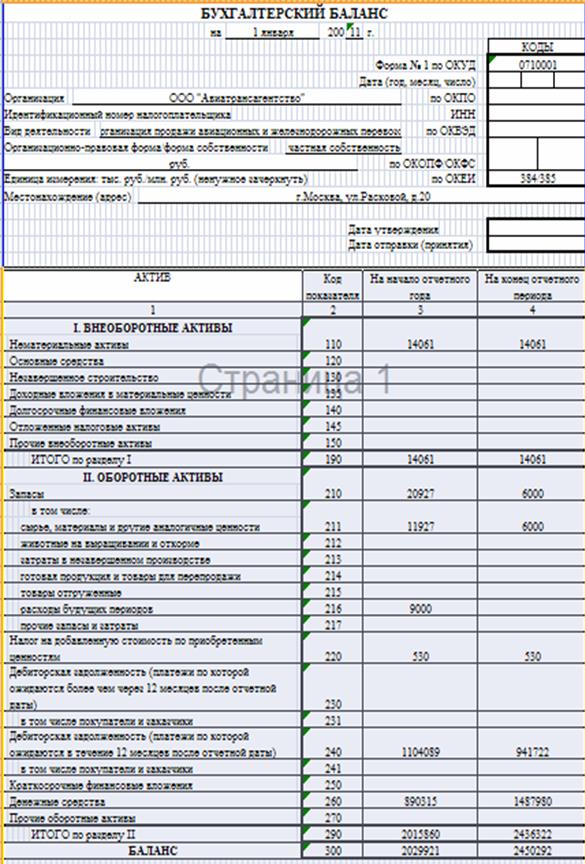

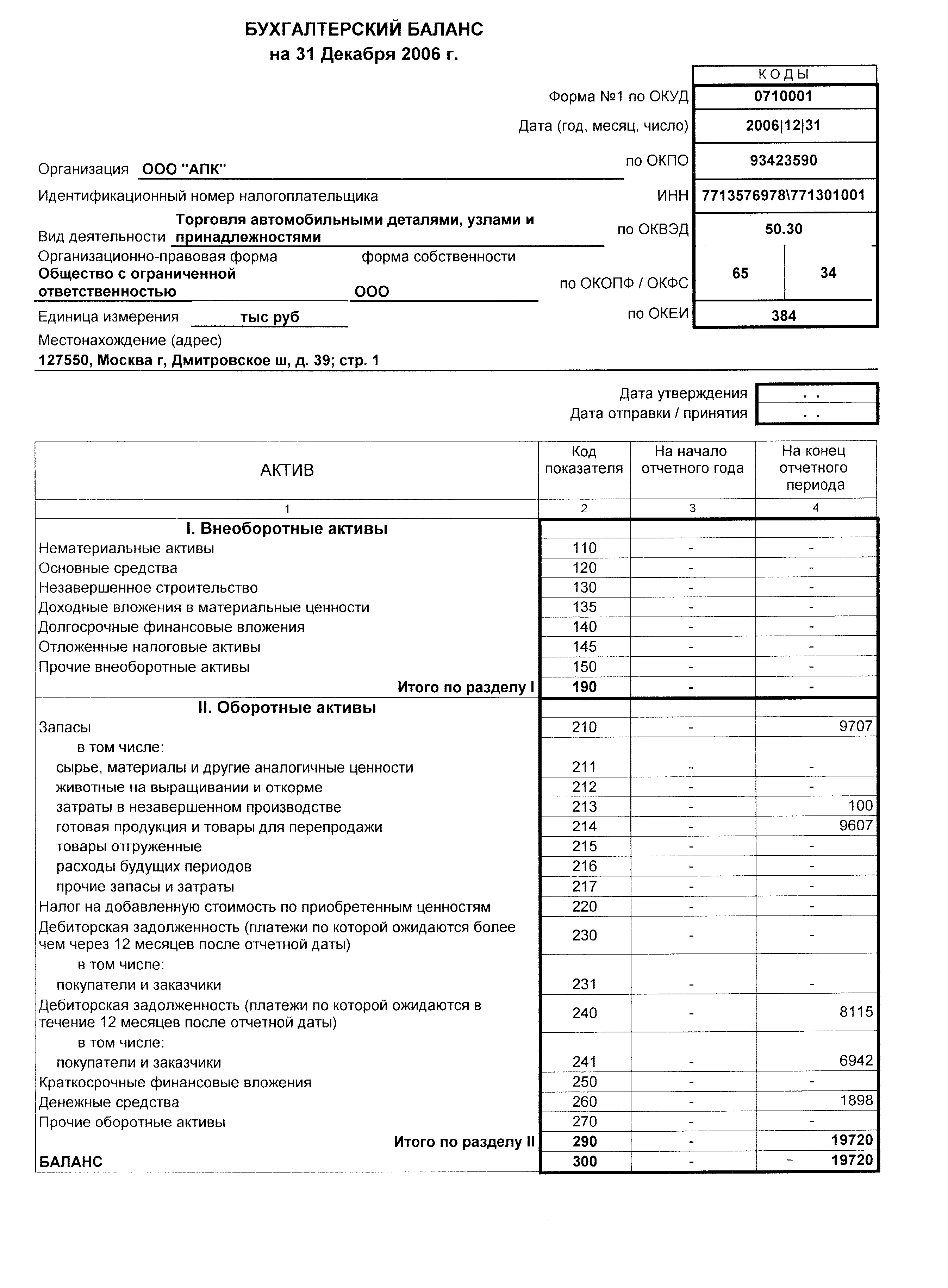

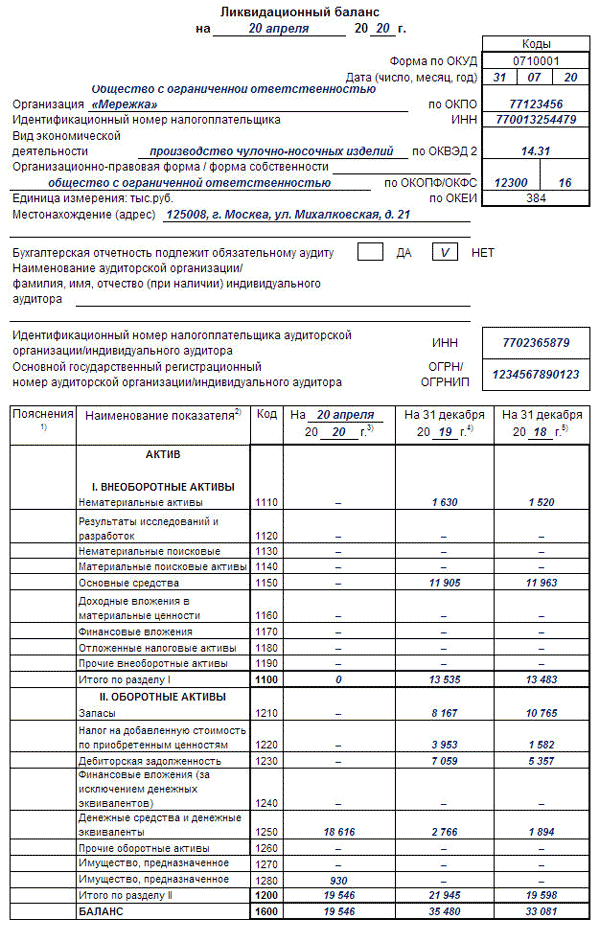

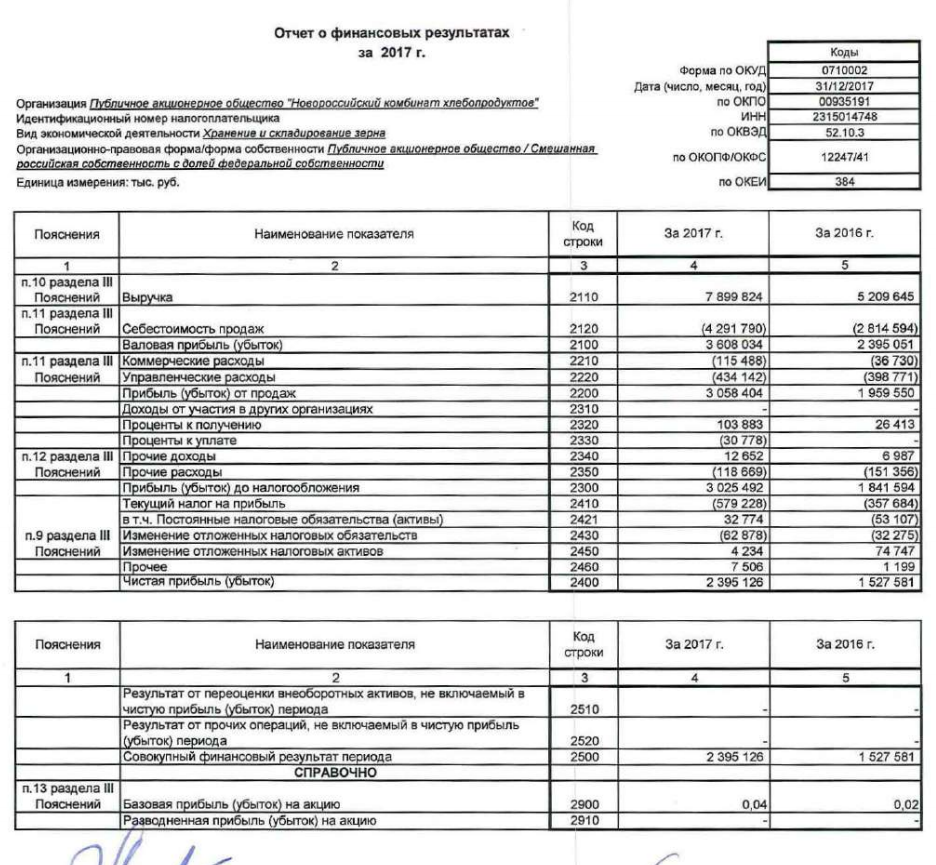

Финансовая отчетность на практическом примере

Финансовая отчетность – информация о финансовом положении, результатах деятельности и изменениях в финансовом положении индивидуального предпринимателя или организации. Составить ее правильно и без ошибок поможет эксперт.

Целью бухгалтерского учета и финансовой отчетности является обеспечение заинтересованных лиц полной и достоверной информацией о финансовом положении, результатах деятельности и изменениях в финансовом положении индивидуальных предпринимателей (ИП) и организаций.

Отчетным периодом для годовой финансовой отчетности является календарный год начиная с 1 января по 31 декабря. Первый отчетный год для вновь созданной организации начинается с момента ее государственной регистрации по 31 декабря того же года.

Систему бухгалтерского учета и финансовой отчетности в РК регулирует Закон РК «О бухгалтерском учете и финансовой отчетности» от 28 февраля 2007 года № 234-III (далее – Закон о бухгалтерском учете).

Законом о бухгалтерском учете установлена обязанность всех ИП и юридических лиц вести бухгалтерский учет и составлять финансовую отчетность, за исключением ИП, соответствующих одновременно следующим условиям:

1) применяют в соответствии с налоговым законодательством РК специальные налоговые режимы на основе патента, упрощенной декларации;

2) не состоят на регистрационном учете по НДС;

3) не являются субъектами естественных монополий.

В Казахстане утверждены три стандарта, регламентирующих правила составления финансовой отчетности, которым должны следовать организации: Национальный стандарт финансовой отчетности (НСФО) либо по выбору: Международные стандарты финансовой отчетности (МСФО), Международные стандарты финансовой отчетности для предприятий малого и среднего бизнеса (МСФО для МСБ).

Финансовая отчетность, за исключением отчетности государственных учреждений, включает в себя:

1) бухгалтерский баланс;

2) отчет о прибылях и убытках;

3) отчет о движении денежных средств;

4) отчет об изменениях в капитале;

5) пояснительную записку.

Для того чтобы финансовая отчетность обеспечивала достижение своей главной цели – представление информации о финансовом положении, финансовых результатах и денежных потоках организации, она должна быть достоверной.

На практике составление финансовой отчетности начинается с проверки бухгалтерской оборотно-сальдовой ведомости за период. Необходимо убедиться, что все сальдо на постоянных счетах не имеют кредитовых остатков на активных счетах и дебетовых остатков на пассивных счетах на конец отчетного периода. Также необходимо проверить, что транзитные счета не имеют сальдо в конце отчетного периода и перенесены на постоянные счета.

Финансовая отчетность составляется на основе оборотно-сальдовой ведомости. За основу соответствия конкретных счетов статьям «Бухгалтерский баланс» и «Отчет о прибылях и убытках» (ОПУ) возможно взять пояснения к заполнению финансовой отчетности, утвержденные приказом министра финансов РК от 28 июня 2017 года № 404.

За основу соответствия конкретных счетов статьям «Бухгалтерский баланс» и «Отчет о прибылях и убытках» (ОПУ) возможно взять пояснения к заполнению финансовой отчетности, утвержденные приказом министра финансов РК от 28 июня 2017 года № 404.

Пример

ТОО «А» является субъектом малого предпринимательства и составляет финансовую отчетность в соответствии с НСФО. Следует составить финансовую отчетность.

Оборотно-сальдовая ведомость ТОО «А» за 2018 год

тенге

Составим баланс с учетом соответствия счетов оборотно-сальдовой ведомости строкам финансовой отчетности.

Бухгалтерский баланс ТОО «А» на 31 декабря 2018 года

тенге

Отчет о прибылях и убытках составляем в соответствии транзитных счетов оборотно-сальдовой ведомости строкам финансовой отчетности.

Отчет о прибылях и убытках ТОО «А» за 2018 год

тенге

При составлении отчета о движении денежных средств необходимо проконтролировать соответствие сумм по строкам:

– сумма в строке 140 за предыдущий период в отчете о движении денежных средств должна соответствовать строке 010 баланса на начало отчетного периода;

– сумма в строке 150 за отчетный период в отчете о движении денежных средств должна соответствовать строке 010 баланса на конец отчетного периода.

Отчет о движении денежных средств ТОО «А» за 2018 год (прямой метод)

тенге

Для контроля правильности составления отчета об изменениях в капитале необходимо сверить суммы уставного капитала и нераспределенной прибыли в отчете и балансе на начало и конец отчетного периода.

Отчет об изменениях в собственном капитале ТОО «А» за 2018 год

тенге

Для того чтобы отчетность, составленная в соответствии с требованиями законодательства РК, соответствовала нормам МСФО, необходимо внести корректировки.

Возможных корректировок, связанных с различием требований МСФО и законодательства РК, огромное множество. Рассмотрим некоторые из них:

Перечень и формы годовой финансовой отчетности для публикации организациями публичного интереса разрабатываются и утверждаются уполномоченным органом (приказ министра финансов РК от 28 июня 2017 года № 404).

В соответствии с пунктом 7 статьи 19 Закона о бухгалтерском учете, организации публичного интереса обязаны сдавать в депозитарий финансовую отчетность в порядке, установленном Правительством РК, в срок до 31 августа года, следующего за отчетным.

Объем, формы и порядок составления финансовой отчетности государственных учреждений, за исключением Национального Банка РК, устанавливаются бюджетным законодательством РК.

Постоянство клиентского IP-адреса или исходный IP-хэш Балансировка нагрузки

Ну это примерно то же самое! Зависит от людей, среды, продуктов и т. д. В этой статье я могу использовать оба из них, но имейте в виду, что оба они указывают на IP-адрес, который используется для подключения к службе, для которой выполняется балансировка нагрузки.

Балансировка нагрузки — это возможность распределять запросы между пулом серверов, которые предоставляют одну и ту же услугу. По определению это означает, что любой запрос может быть отправлен на любой сервер в пуле.

Некоторым приложениям требуется липкость между клиентом и сервером: это означает, что все запросы от клиента должны быть отправлены на один и тот же сервер. В противном случае сеанс приложения может быть прерван, что может негативно сказаться на клиенте.

У нас может быть много способов привязать пользователя к серверу, которые уже обсуждались в этом блоге (прочитайте балансировку нагрузки, сходство, постоянство, закрепленные сеансы: что вам нужно знать) (и многие другие статьи могут последовать).

Тем не менее, иногда единственной информацией, на которую мы можем «полагаться» для выполнения прилипания, является IP-адрес клиента (или источника).

Обратите внимание, что это не оптимально, потому что:

* многие клиенты могут быть «спрятаны» за одним IP-адресом (брандмауэр, прокси и т. д.)

* клиент может изменить свой IP-адрес во время сеанса

* клиент может использовать несколько IP-адресов адреса

* и т.д…

Существует два способа выполнения сопоставления исходного IP-адреса:

1. Использование специального алгоритма балансировки нагрузки: хэш на исходном IP-адресе

2. Использование флеш-таблицы в памяти (и циклического алгоритма балансировки нагрузки)

На самом деле, основная цель этой статьи состояла в том, чтобы представить оба метода, которые довольно часто неправильно понимают, и показать плюсы и минусы каждого, чтобы люди могли принять правильное решение при настройке своего Load-Balancer.

Алгоритм балансировки нагрузки хэша IP-адреса источника

Этот алгоритм является детерминированным . Это означает, что если никакие элементы не участвуют в вычислении хэша, то результат будет таким же. 2 могут применять один и тот же хэш, следовательно, балансировка нагрузки выполняется одинаково, что делает аварийное переключение балансировщика нагрузки прозрачным.

К исходному IP-адресу входящего запроса применена хэш-функция. Хэш должен учитывать количество серверов и вес каждого сервера.

Следующие события могут привести к изменению хэша и, таким образом, могут по-разному перенаправлять трафик с течением времени:

* сервер в пуле выходит из строя

* сервер в пуле поднимается вверх

* изменение веса сервера

Основная проблема с алгоритмом балансировки хеш-нагрузки исходного IP заключается в том, что каждое изменение может перенаправить ВСЕХ на другой сервер!!!

Вот почему некоторые хорошие балансировщики нагрузки внедрили согласованный метод хеширования, который гарантирует, что, например, в случае сбоя сервера перенаправляются только клиенты, подключенные к этому серверу.

Обратной стороной последовательного хеширования является то, что оно не обеспечивает идеального хеширования, поэтому в ферме из 4 серверов одни могут получать больше клиентов, чем другие.

Обратите внимание, что когда отказавший сервер возвращается, его «застрявшие» пользователи (определяемые хэшем) будут перенаправлены на него.

При использовании такого алгоритма нет накладных расходов на ЦП или память.

Пример конфигурации в HAProxy или в ALOHA Load-Balancer:

источник баланса согласованный хеш-тип

Сохранение исходного IP-адреса с использованием флеш-таблицы

Балансировщик нагрузки создает таблицу в памяти для хранения исходного IP-адреса и затронутого сервера из пула.

Мы можем положиться на любой недетерминированный алгоритм балансировки нагрузки, такой как циклический алгоритм или наименьшее соединение (обычно это зависит от типа приложения, для которого выполняется балансировка нагрузки).

После того, как клиент привязан к серверу, он остается привязанным до тех пор, пока не истечет срок действия записи в таблице ИЛИ сервер не выйдет из строя.

В памяти есть служебные данные для хранения информации о закреплении. В HAProxy накладные расходы довольно низкие: 40 МБ для 1 000 000 адресов IPv4.

Одним из основных преимуществ использования флеш-таблицы является то, что при восстановлении отказавшего сервера никакие существующие сеансы не будут перенаправлены на него.До него могут добраться только новые входящие IP-адреса. Так что никакого влияния на пользователей.

Также можно синхронизировать таблицы в памяти между несколькими HAProxy или ALOHA Load-Balancers , что делает аварийное переключение LB прозрачным.

Пример конфигурации в HAProxy или в ALOHA Load-Balancer :

тип палки-таблицы размер IP 1 м срок действия 1 час придерживаться источника

Балансировка нагрузки HTTP | НГИНКС Плюс

Балансировка нагрузки HTTP-трафика между веб-группами или группами серверов приложений с несколькими алгоритмами и расширенными функциями, такими как медленный запуск и сохранение сеанса.

Обзор

Балансировка нагрузки между несколькими экземплярами приложения — это широко используемый метод оптимизации использования ресурсов, увеличения пропускной способности, уменьшения задержки и обеспечения отказоустойчивости конфигураций.

Посмотрите вебинар NGINX Plus для балансировки нагрузки и масштабирования по запросу, чтобы подробно изучить методы, которые пользователи NGINX используют для создания крупномасштабных высокодоступных веб-сервисов.

NGINX и NGINX Plus можно использовать в различных сценариях развертывания в качестве очень эффективного балансировщика нагрузки HTTP.

Проксирование HTTP-трафика на группу серверов

Чтобы начать использовать NGINX Plus или NGINX Open Source для балансировки нагрузки HTTP-трафика на группу серверов, сначала необходимо определить группу с помощью директивы upstream . Директива находится в контексте http .

Серверы в группе настраиваются с помощью директивы server (не путать с блоком server , который определяет виртуальный сервер, работающий на NGINX). Например, следующая конфигурация определяет группу с именем backend и состоит из трех конфигураций серверов (которые могут разрешаться более чем в трех фактических серверах):

Например, следующая конфигурация определяет группу с именем backend и состоит из трех конфигураций серверов (которые могут разрешаться более чем в трех фактических серверах):

http {

восходящий сервер {

сервер backend1.example.com вес=5;

сервер backend2.example.com;

резервная копия сервера 192.0.0.1;

}

}

Для передачи запросов к группе серверов имя группы указывается в директиве proxy_pass (или fastcgi_pass , memcached_pass , scgi_pass , или директиве uws8gi_passives protocols.) В следующем примере виртуальный сервер, работающий на NGINX, передает все запросы в группу backend upstream, определенную в предыдущем примере:

сервер {

место расположения / {

прокси_пасс http://бэкэнд;

}

}

В следующем примере объединены два приведенных выше фрагмента и показано, как проксировать HTTP-запросы к группе внутренних серверов . Группа состоит из трех серверов, на двух из которых запущены экземпляры одного и того же приложения, а третий является сервером резервного копирования.Поскольку в восходящем блоке

Группа состоит из трех серверов, на двух из которых запущены экземпляры одного и того же приложения, а третий является сервером резервного копирования.Поскольку в восходящем блоке не указан алгоритм балансировки нагрузки, NGINX использует алгоритм по умолчанию, Round Robin:

http {

восходящий сервер {

сервер backend1.example.com;

сервер backend2.example.com;

резервная копия сервера 192.0.0.1;

}

сервер {

место расположения / {

прокси_пасс http://бэкэнд;

}

}

}

Выбор метода балансировки нагрузки

NGINX Open Source поддерживает четыре метода балансировки нагрузки, а NGINX Plus добавляет еще два метода:

Round Robin — запросы равномерно распределяются по серверам с учетом веса серверов.Этот метод используется по умолчанию (нет директивы для его включения):

восходящий сервер { # для циклического перебора не указан метод балансировки нагрузки сервер backend1. example.com;

сервер backend2.example.com;

}

example.com;

сервер backend2.example.com;

}

Наименьшее количество подключений — запрос отправляется на сервер с наименьшим количеством активных подключений, опять же с учетом весов серверов:

восходящий сервер { наименьшее_соединение; сервер backend1.example.ком; сервер backend2.example.com; }IP Hash — сервер, на который отправляется запрос, определяется по IP-адресу клиента. В этом случае для вычисления хеш-значения используются либо первые три октета адреса IPv4, либо весь адрес IPv6. Метод гарантирует, что запросы с одного и того же адреса попадают на один и тот же сервер, если он недоступен.

восходящий сервер { ip_хэш; сервер backend1.example.com; серверная часть2.пример.com; }Если один из серверов необходимо временно исключить из ротации балансировки нагрузки, его можно пометить параметром down, чтобы сохранить текущее хеширование клиентских IP-адресов.

Запросы, которые должны были быть обработаны этим сервером, автоматически отправляются на следующий сервер в группе:

Запросы, которые должны были быть обработаны этим сервером, автоматически отправляются на следующий сервер в группе:восходящий сервер { сервер backend1.example.com; сервер backend2.example.com; сервер backend3.example.com не работает; }Generic Hash — сервер, на который отправляется запрос, определяется определяемым пользователем ключом, который может быть текстовой строкой, переменной или их комбинацией.Например, ключ может быть парой исходного IP-адреса и порта или URI, как в этом примере:

.восходящий сервер { хеш $request_uri согласован; сервер backend1.example.com; сервер backend2.example.com; }Дополнительный согласованный параметр директивы

hashвключает балансировку нагрузки ketama с согласованным хэшем. Запросы равномерно распределяются по всем вышестоящим серверам на основе заданного пользователем значения хешированного ключа. Если вышестоящий сервер добавляется в вышестоящую группу или удаляется из нее, переназначаются только несколько ключей, что сводит к минимуму промахи в кэше в случае кэш-серверов с балансировкой нагрузки или других приложений, накапливающих состояние.

Если вышестоящий сервер добавляется в вышестоящую группу или удаляется из нее, переназначаются только несколько ключей, что сводит к минимуму промахи в кэше в случае кэш-серверов с балансировкой нагрузки или других приложений, накапливающих состояние.Наименьшее время (только NGINX Plus) — для каждого запроса NGINX Plus выбирает сервер с наименьшей средней задержкой и наименьшим количеством активных соединений, где наименьшая средняя задержка рассчитывается на основе одного из следующих параметров

наименьшего_времени. включена директива:-

заголовок— Время получения первого байта от сервера -

last_byte— Время получения полного ответа от сервера -

last_byte inflight— Время получения полного ответа от сервера с учетом незавершенных запросов

восходящий сервер { заголовок наименьшее_время; серверная часть1.пример.com; сервер backend2. example.com;

}

example.com;

}

-

Random — каждый запрос будет передан на случайно выбранный сервер. Если указан параметр

two, то сначала NGINX случайным образом выбирает два сервера с учетом весов серверов, а затем выбирает один из этих серверов указанным методом:-

less_conn— Наименьшее количество активных подключений -

less_time=header(NGINX Plus) — наименьшее среднее время получения заголовка ответа от сервера ($upstream_header_time) -

наименьшее_время=последний_байт(NGINX Plus) — наименьшее среднее время получения полного ответа от сервера ($upstream_response_time)

восходящий сервер { случайные два наименьшее_время=последний_байт; серверная часть1.пример.com; сервер backend2.example.com; сервер backend3.example.com; сервер backend4.example.com; }Метод балансировки нагрузки Random следует использовать для распределенных сред, в которых несколько балансировщиков нагрузки передают запросы одному и тому же набору серверных частей.

Для сред, в которых балансировщик нагрузки имеет полное представление обо всех запросах, используйте другие методы балансировки нагрузки, такие как циклический перебор, наименьшее количество подключений и наименьшее время.

Для сред, в которых балансировщик нагрузки имеет полное представление обо всех запросах, используйте другие методы балансировки нагрузки, такие как циклический перебор, наименьшее количество подключений и наименьшее время.-

Примечание: При настройке любого метода, кроме Round Robin, поместите соответствующую директиву (

hash,ip_hash,last_conn,last_timeилиrandom 90s 9083 директивы server) над списком директив server .восходящий блок {}.

Вес сервера

По умолчанию NGINX распределяет запросы между серверами в группе в соответствии с их весами, используя метод Round Robin. Параметр weight директивы server задает вес сервера; по умолчанию 1 :

восходящий сервер {

сервер backend1.example.com вес=5;

сервер backend2. example.com;

резервная копия сервера 192.0.0.1;

}

example.com;

резервная копия сервера 192.0.0.1;

}

В примере backend1.example.com имеет вес 5 ; два других сервера имеют вес по умолчанию ( 1 ), но один с IP-адресом 192.0.0.1 помечен как резервный сервер и не получает запросы, если оба других сервера недоступны. При такой конфигурации весов из каждых 6 запросов 5 отправляются на backend1.example.com и 1 на backend2.example.com .

Медленный старт сервера

Функция медленного запуска сервера предотвращает перегрузку недавно восстановленного сервера соединениями, что может привести к истечению времени ожидания и повторной пометке сервера как неисправного.

В NGINX Plus медленный запуск позволяет вышестоящему серверу постепенно восстанавливать свой вес с 0 до номинального значения после того, как он был восстановлен или стал доступным. Это можно сделать с помощью параметра

Это можно сделать с помощью параметра slow_start в директиве server :

восходящий сервер {

сервер backend1.example.com slow_start=30s;

сервер backend2.example.com;

резервная копия сервера 192.0.0.1;

}

Значение времени (здесь 30 секунды) устанавливает время, в течение которого NGINX Plus увеличивает количество подключений к серверу до полного значения.

Обратите внимание, что если в группе только один сервер, параметры max_fails , fail_timeout и slow_start директивы server игнорируются, и сервер никогда не считается недоступным.

Включение сохранения сеанса

Сохранение сеанса означает, что NGINX Plus идентифицирует сеансы пользователей и направляет все запросы в данном сеансе на один и тот же вышестоящий сервер.

NGINX Plus поддерживает три метода сохранения сеанса.Методы задаются директивой sticky . (Для сохранения сеанса с NGINX с открытым исходным кодом используйте директиву

(Для сохранения сеанса с NGINX с открытым исходным кодом используйте директиву hash или ip_hash , как описано выше.)

Sticky cookie — NGINX Plus добавляет сеансовый cookie к первому ответу от вышестоящей группы и идентифицирует сервер, отправивший ответ. Следующий запрос клиента содержит значение cookie, и NGINX Plus направляет запрос на вышестоящий сервер, ответивший на первый запрос:

.восходящий сервер { серверная часть1.пример.com; сервер backend2.example.com; sticky cookie srv_id expires=1h domain=.example.com path=/; }В примере параметр

srv_idзадает имя файла cookie. Необязательный параметрexpiresзадает время, в течение которого браузер сохраняет файл cookie (здесь1час). Необязательный параметрdomainопределяет домен, для которого устанавливается файл cookie, а необязательный параметрpathопределяет путь, для которого устанавливается файл cookie. Это самый простой метод сохранения сеанса.

Это самый простой метод сохранения сеанса.Sticky route — NGINX Plus назначает «маршрут» клиенту при получении первого запроса. Все последующие запросы сравниваются с параметром

routeдирективыserverдля идентификации сервера, на который проксируется запрос. Информация о маршруте берется либо из файла cookie, либо из URI запроса.восходящий сервер { сервер backend1.example.com route=a; серверная часть2.маршрут example.com=b; фиксированный маршрут $route_cookie $route_uri; }Метод фиксированного обучения — NGINX Plus сначала находит идентификаторы сеансов, проверяя запросы и ответы. Затем NGINX Plus «узнает», какой восходящий сервер соответствует какому идентификатору сеанса. Как правило, эти идентификаторы передаются в файле cookie HTTP. Если запрос содержит уже «выученный» идентификатор сеанса, NGINX Plus перенаправляет запрос на соответствующий сервер:

.

восходящий сервер { серверная часть1.пример.com; сервер backend2.example.com; липкое обучение создать=$upstream_cookie_examplecookie lookup=$cookie_examplecookie зона = client_sessions: 1 м таймаут=1ч; }В этом примере один из вышестоящих серверов создает сеанс, устанавливая файл cookie

EXAMPLECOOKIEв ответе.Обязательный параметр

createзадает переменную, указывающую, как создается новый сеанс. В этом примере новые сеансы создаются из файла cookieEXAMPLECOOKIE, отправленного вышестоящим сервером.Обязательный параметр поиска

EXAMPLECOOKIE, отправленном клиентом.Обязательный параметр

zoneуказывает зону общей памяти, в которой хранится вся информация о закрепленных сеансах. В нашем примере зона называется client_sessions и имеет размер1мегабайт.

Это более сложный метод сохранения сеанса, чем два предыдущих, поскольку он не требует хранения файлов cookie на стороне клиента: вся информация хранится на стороне сервера в зоне общей памяти.

При наличии в кластере нескольких экземпляров NGINX, использующих метод «липкого обучения», возможна синхронизация содержимого их зон общей памяти при следующих условиях:

- зоны имеют одинаковое имя

- функциональность

zone_syncнастроена для каждого экземпляра - указан параметр синхронизации

липкое обучение создать=$upstream_cookie_examplecookie lookup=$cookie_examplecookie зона = client_sessions: 1 м таймаут=1ч синхронизировать; }Дополнительные сведения см. в разделе Совместное использование состояний среды выполнения в кластере.

Ограничение количества подключений

В NGINX Plus можно ограничить количество активных подключений к вышестоящему серверу, указав максимальное количество с помощью параметра max_conns .

Если достигнут предел max_conns , запрос помещается в очередь для дальнейшей обработки при условии, что также включена директива queue для установки максимального количества запросов, которые могут одновременно находиться в очереди:

восходящий сервер {

серверная часть1.пример.com max_conns=3;

сервер backend2.example.com;

очередь 100 тайм-аут=70;

}

Если очередь заполнена запросами или вышестоящий сервер не может быть выбран в течение времени ожидания, указанного необязательным параметром timeout , клиент получает сообщение об ошибке.

Обратите внимание, что ограничение max_conns игнорируется, если в других рабочих процессах открыты незанятые keepalive соединения. В результате общее количество подключений к серверу может превысить значение max_conns в конфигурации, в которой память совместно используется несколькими рабочими процессами.

Настройка проверок работоспособности

NGINX может постоянно тестировать вышестоящие HTTP-серверы, избегать отказавших серверов и корректно добавлять восстановленные серверы в группу с балансировкой нагрузки.

Инструкции по настройке проверки работоспособности для HTTP см. в разделе Проверка работоспособности HTTP.

Совместное использование данных с несколькими рабочими процессами

Если вышестоящий блок не включает директиву зоны , каждый рабочий процесс сохраняет свою собственную копию конфигурации группы серверов и собственный набор связанных счетчиков.Счетчики включают текущее количество подключений к каждому серверу в группе и количество неудачных попыток передать запрос на сервер. В результате конфигурация группы серверов не может быть изменена динамически.

Если директива зоны включена в блок восходящего потока , конфигурация группы восходящего потока хранится в области памяти, совместно используемой всеми рабочими процессами. Этот сценарий динамически настраивается, поскольку рабочие процессы получают доступ к одной и той же копии конфигурации группы и используют одни и те же связанные счетчики.

Этот сценарий динамически настраивается, поскольку рабочие процессы получают доступ к одной и той же копии конфигурации группы и используют одни и те же связанные счетчики.

Директива зоны является обязательной для активных проверок работоспособности и динамической реконфигурации вышестоящей группы. Однако другие функции вышестоящих групп также могут выиграть от использования этой директивы.

Например, если конфигурация группы не используется совместно, каждый рабочий процесс ведет собственный счетчик неудачных попыток передать запрос на сервер (устанавливается параметром max_fails). В этом случае каждый запрос попадает только к одному рабочему процессу. Когда рабочий процесс, выбранный для обработки запроса, не может передать запрос на сервер, другие рабочие процессы ничего об этом не знают.В то время как некоторые рабочие процессы могут считать сервер недоступным, другие могут по-прежнему отправлять запросы на этот сервер. Чтобы сервер окончательно считался недоступным, количество неудачных попыток за время, заданное параметром fail_timeout , должно равняться max_fails , умноженному на количество рабочих процессов. С другой стороны, директива

С другой стороны, директива зоны гарантирует ожидаемое поведение.

Точно так же метод балансировки нагрузки с наименьшими подключениями может не работать должным образом без директивы зоны , по крайней мере, при низкой нагрузке.Этот метод передает запрос на сервер с наименьшим количеством активных подключений. Если конфигурация группы не используется совместно, каждый рабочий процесс использует собственный счетчик количества подключений и может отправить запрос на тот же сервер, на который только что отправил запрос другой рабочий процесс. Однако вы можете увеличить количество запросов, чтобы уменьшить этот эффект. При высокой нагрузке запросы распределяются между рабочими процессами равномерно, и метод Least Connections работает как положено.

Установка размера зоны

Невозможно порекомендовать идеальный размер зоны памяти, поскольку модели использования сильно различаются. Требуемый объем памяти определяется тем, какие функции (такие как сохранение сеанса, проверки работоспособности или повторное разрешение DNS) включены, а также тем, как идентифицируются вышестоящие серверы.

Например, при использовании метода сохраняемости сеанса sticky_route и включенной одиночной проверки работоспособности зона размером 256 КБ может вместить информацию об указанном количестве вышестоящих серверов:

- 128 серверов (каждый определяется как пара IP-адрес:порт)

- 88 серверов (каждый определяется как пара имя хоста:порт, где имя хоста разрешается в один IP-адрес)

- 12 серверов (каждый определяется как пара имя хоста:порт, где имя хоста разрешается в несколько IP-адресов)

Настройка балансировки нагрузки HTTP с использованием DNS

Конфигурацию группы серверов можно изменить во время выполнения с помощью DNS.

Для серверов в вышестоящей группе, которые идентифицируются доменным именем в директиве server , NGINX Plus может отслеживать изменения в списке IP-адресов в соответствующей записи DNS и автоматически применять изменения к балансировке нагрузки для вышестоящей группы. , не требуя перезагрузки. Это можно сделать, включив директиву

, не требуя перезагрузки. Это можно сделать, включив директиву resolver в блок http вместе с параметром resolve в директиву server :

http {

резольвер 10.0.0.1 действительный=300 с ipv6=выкл.;

резолвер_таймаут 10 с;

сервер {

место расположения / {

прокси_пасс http://бэкэнд;

}

}

восходящий сервер {

бэкенд зоны 32k;

наименьшее_соединение;

# ...

сервер backend1.example.com разрешает;

сервер backend2.example.com разрешает;

}

}

В этом примере параметр Resolve для директивы server указывает NGINX Plus периодически повторно разрешать backend1.example.com и backend2.example.com доменных имен в IP-адреса.

Директива распознавателя определяет IP-адрес DNS-сервера, на который NGINX Plus отправляет запросы (здесь 10. ). По умолчанию NGINX Plus повторно разрешает записи DNS с частотой, заданной временем жизни (TTL) в записи, но вы можете переопределить значение TTL с помощью допустимого параметра  0.0.1

0.0.1 ; в примере это 300 секунды или 5 минуты.

Необязательный параметр ipv6=off означает, что для балансировки нагрузки используются только адреса IPv4, хотя по умолчанию поддерживается разрешение как адресов IPv4, так и IPv6.

Если доменное имя разрешается в несколько IP-адресов, адреса сохраняются в вышестоящей конфигурации и распределяются по нагрузке. В нашем примере нагрузка на серверы распределяется по методу балансировки нагрузки с наименьшим количеством подключений. Если список IP-адресов для сервера изменился, NGINX Plus немедленно начинает балансировку нагрузки по новому набору адресов.

Балансировка нагрузки серверов Microsoft Exchange

В NGINX Plus R7 и более поздних версиях NGINX Plus может проксировать трафик Microsoft Exchange на сервер или группу серверов и балансировать нагрузку.

Для настройки балансировки нагрузки серверов Microsoft Exchange:

В блоке

locationнастройте прокси для вышестоящей группы серверов Microsoft Exchange с директивойproxy_pass:местоположение / { прокси_пасс https://exchange; # ... }Чтобы соединения Microsoft Exchange проходили на вышестоящие серверы, в блоке

locationустановите для директивыproxy_http_versionзначение1.1, а для директивыproxy_set_header— значениеConnection "", как и для keepalive подключение:местоположение / { # ... прокси_http_версия 1.1; proxy_set_header Соединение ""; # ... }В блоке

httpнастройте восходящую группу серверов Microsoft Exchange с восходящим блокомproxy_passна шаге 1. Затем укажите директиву

Затем укажите директиву ntlm, чтобы разрешить серверам в группе принимать запросы с аутентификацией NTLM:http { # ... восходящий обмен { зона обмена 64k; нтлм; # ... } }Добавьте серверы Microsoft Exchange в вышестоящую группу и при необходимости укажите метод балансировки нагрузки:

http { # ... восходящий обмен { зона обмена 64k; нтлм; обмен серверами1.пример.com; сервер exchange2.example.com; # ... } }

Полный пример NTLM

http {

# ...

восходящий обмен {

зона обмена 64k;

нтлм;

сервер exchange1.example.com;

сервер exchange2.example.com;

}

сервер {

слушать 443 ssl;

ssl_certificate /etc/nginx/ssl/company.com.crt;

ssl_certificate_key /etc/nginx/ssl/company. com.key;

ssl_протоколы TLSv1 TLSv1.1 TLSv1.2;

место расположения / {

прокси_пасс https://exchange;

прокси_http_версия 1.1;

proxy_set_header Соединение "";

}

}

}

com.key;

ssl_протоколы TLSv1 TLSv1.1 TLSv1.2;

место расположения / {

прокси_пасс https://exchange;

прокси_http_версия 1.1;

proxy_set_header Соединение "";

}

}

}

Дополнительные сведения о настройке Microsoft Exchange и NGINX Plus см. в руководстве по развертыванию балансировки нагрузки серверов Microsoft Exchange с NGINX Plus.

Динамическая конфигурация с использованием API NGINX Plus

В NGINX Plus конфигурация группы вышестоящих серверов может динамически изменяться с помощью API NGINX Plus.Команду конфигурации можно использовать для просмотра всех серверов или определенного сервера в группе, изменения параметра для определенного сервера и добавления или удаления серверов. Дополнительные сведения и инструкции см. в разделе Настройка динамической балансировки нагрузки с помощью API NGINX Plus.

Использование nginx в качестве балансировщика нагрузки HTTP

Использование nginx в качестве балансировщика нагрузки HTTP

Введение

Балансировка нагрузки между несколькими экземплярами приложений является широко используемой

метод оптимизации использования ресурсов, максимизация пропускной способности,

сокращение задержки и обеспечение отказоустойчивых конфигураций.

Можно использовать nginx как очень эффективный балансировщик нагрузки HTTP для распределить трафик на несколько серверов приложений и улучшить производительность, масштабируемость и надежность веб-приложений с nginx.

Методы балансировки нагрузки

Следующие механизмы (или методы) балансировки нагрузки поддерживаются в нгинкс:

- round-robin — запросы к серверам приложений распределяются круговым способом,

- наименее подключенный — следующий запрос назначается серверу с наименьшее количество активных подключений,

- ip-hash — хэш-функция используется для определения того, какой сервер должен быть выбранным для следующего запроса (на основе IP-адреса клиента).

Конфигурация балансировки нагрузки по умолчанию

Простейшая конфигурация для балансировки нагрузки с помощью nginx может выглядеть как следующее:

http {

вверх по течению myapp1 {

сервер srv1.example.com;

сервер srv2. example.com;

сервер srv3.example.com;

}

сервер {

слушать 80;

место расположения / {

прокси_пасс http://myapp1;

}

}

}

example.com;

сервер srv3.example.com;

}

сервер {

слушать 80;

место расположения / {

прокси_пасс http://myapp1;

}

}

}

В приведенном выше примере есть 3 экземпляра одного и того же приложения. работает на srv1-srv3.Если метод балансировки нагрузки специально не настроен, по умолчанию используется циклический алгоритм. Все запросы проксируется на группу серверов myapp1, а nginx применяет HTTP-загрузку балансировка для распределения запросов.

Реализация обратного прокси в nginx включает балансировку нагрузки для HTTP, HTTPS, FastCGI, uwsgi, SCGI, memcached и gRPC.

Чтобы настроить балансировку нагрузки для HTTPS вместо HTTP, просто используйте «https». как протокол.

При настройке балансировки нагрузки для FastCGI, uwsgi, SCGI, memcached или gRPC используйте fastcgi_pass, uwsgi_pass, scgi_pass, memcached_pass и grpc_pass директивы соответственно.

Балансировка нагрузки с наименьшим количеством подключений

Еще одна дисциплина балансировки нагрузки — наименее подключенная. Наименее подключенный позволяет контролировать нагрузку на приложение

случаев более справедливо в ситуации, когда часть запросов

потребуется больше времени для завершения.

Наименее подключенный позволяет контролировать нагрузку на приложение

случаев более справедливо в ситуации, когда часть запросов

потребуется больше времени для завершения.

При балансировке нагрузки с наименьшим количеством подключений nginx постарается не перегружать загруженный сервер приложений с чрезмерными запросами, раздающими новые вместо этого запросы к менее загруженному серверу.

Балансировка нагрузки по наименьшему количеству подключений в nginx активируется, когда Директива less_conn используется как часть конфигурации группы серверов:

вверх по течению myapp1 {

наименьшее_соединение;

сервер срв1.пример.com;

сервер srv2.example.com;

сервер srv3.example.com;

}

Постоянство сеанса

Обратите внимание, что при циклическом переборе или нагрузке с наименьшим количеством подключений

балансировка, каждый последующий запрос клиента может быть потенциально

распространяется на другой сервер. Нет гарантии, что один и тот же клиент будет всегда

направлены на тот же сервер.

Нет гарантии, что один и тот же клиент будет всегда

направлены на тот же сервер.

Если есть необходимость привязать клиента к конкретному серверу приложений — другими словами, сделать сеанс клиента «липким» или «постоянным» в условия всегда пытаются выбрать конкретный сервер — нагрузка IP-хэша можно использовать уравновешивающий механизм.

С ip-hash IP-адрес клиента используется в качестве ключа хеширования для определить, какой сервер в группе серверов должен быть выбран для запросы клиента. Этот метод гарантирует, что запросы от одного и того же клиента всегда будет направлен на один и тот же сервер за исключением случаев, когда этот сервер недоступен.

Для настройки балансировки нагрузки ip-hash достаточно добавить ip_hash директива для конфигурации группы серверов (upstream):

вверх по течению myapp1 {

ip_хэш;

сервер срв1.пример.com;

сервер srv2.example.com;

сервер srv3.example.com;

}

Взвешенная балансировка нагрузки

Также возможно влиять на алгоритмы балансировки нагрузки nginx даже

далее с помощью серверных весов.

В приведенных выше примерах вес сервера не настроен, что означает что все указанные серверы рассматриваются как одинаково квалифицированные для определенный метод балансировки нагрузки.

В частности, при круговой системе это также означает более или менее равные распределение запросов по серверам — при условии, что их достаточно запросы, и когда запросы обрабатываются единообразно и завершено достаточно быстро.

Когда масса параметр указан для сервера, вес учитывается как часть решения о балансировке нагрузки.

вверх по течению myapp1 {

сервер srv1.example.com вес=3;

сервер srv2.example.com;

сервер srv3.example.com;

}

При такой конфигурации каждые 5 новых запросов будут распределяться по экземпляры приложения следующим образом: 3 запроса будут направлены к srv1, один запрос пойдет к srv2, а другой — к srv3.

Аналогично можно использовать веса с наименее связным и

балансировка нагрузки ip-hash в последних версиях nginx.

Медицинские осмотры

Реализация обратного прокси в nginx включает внутриполосный (или пассивный) проверки работоспособности сервера. Если ответ от определенного сервера завершается с ошибкой, nginx пометит этот сервер как неисправный и попытается временно не выбирайте этот сервер для последующих входящих запросов.

То max_fails директива устанавливает количество последовательных неудачных попыток общаться с сервером, что должно произойти во время сбой_тайм-аут.По умолчанию, max_fails устанавливается на 1. Если установлено значение 0, проверки работоспособности для этого сервера отключены. То fail_timeout Параметр также определяет, как долго сервер будет помечен как неисправный. После fail_timeout интервал после сбоя сервера, nginx начнет изящно зондировать сервер с запросами живого клиента. Если зонды прошли успешно, сервер помечается как работающий.

Дальнейшее чтение

Кроме того, есть больше директив и параметров, управляющих сервером.

балансировка нагрузки в nginx, т. е.г.

proxy_next_upstream,

резервный,

вниз, и

поддерживать активность.

Для получения дополнительной информации, пожалуйста, проверьте наш

справочная документация.

е.г.

proxy_next_upstream,

резервный,

вниз, и

поддерживать активность.

Для получения дополнительной информации, пожалуйста, проверьте наш

справочная документация.

Последний, но тем не менее важный, балансировка нагрузки приложений, проверка работоспособности приложений, мониторинг активности и доступна оперативная перенастройка групп серверов в рамках наших платных подписок NGINX Plus.

В следующих статьях описывается балансировка нагрузки с помощью NGINX Plus. Подробнее:

Внешний обзор балансировки нагрузки HTTP(S) | Облако Google

В этом документе представлены концепции, которые необходимо понимать для настройки Внешняя балансировка нагрузки HTTP(S) Google Cloud.

Внешняя балансировка нагрузки HTTP(S) — это нагрузка уровня 7 на основе прокси-сервера.

балансировщик, который позволяет вам запускать и масштабировать свои службы за

один внешний IP-адрес. Распределение внешней балансировки нагрузки HTTP(S)

Трафик HTTP и HTTPS к бэкэндам, размещенным в различных облаках Google. платформах (таких как Compute Engine, Google Kubernetes Engine (GKE),

облачное хранилище и т. д.), а также внешние серверные части, подключенные через

через Интернет или через гибридное соединение.

Дополнительные сведения см. в разделе Варианты использования.

платформах (таких как Compute Engine, Google Kubernetes Engine (GKE),

облачное хранилище и т. д.), а также внешние серверные части, подключенные через

через Интернет или через гибридное соединение.

Дополнительные сведения см. в разделе Варианты использования.

Режимы работы

Вы можете настроить внешнюю балансировку нагрузки HTTP(S) в следующих режимах:

- Глобальный внешний балансировщик нагрузки HTTP(S). Это глобальная загрузка балансировщик, реализованный как управляемая служба в Google Front Ends (ГФЭ). Это использует Envoy с открытым исходным кодом прокси для поддержки расширенные возможности управления трафиком, такие как зеркалирование трафика, разделение трафика на основе веса, преобразования заголовков на основе запроса/ответа, и больше. Этот балансировщик нагрузки в настоящее время находится в Предварительный просмотр .

- Глобальный внешний балансировщик нагрузки HTTP(S) (классический).

Это классический внешний балансировщик нагрузки HTTP(S), который

является глобальным в Premium Tier, но может быть настроен как региональный в Standard

Уровень.Этот балансировщик нагрузки реализован на Google Front Ends.

(ГФЭ). GFE являются

распределены по всему миру и работают вместе, используя глобальную сеть Google и

плоскость управления.

Это классический внешний балансировщик нагрузки HTTP(S), который

является глобальным в Premium Tier, но может быть настроен как региональный в Standard

Уровень.Этот балансировщик нагрузки реализован на Google Front Ends.

(ГФЭ). GFE являются

распределены по всему миру и работают вместе, используя глобальную сеть Google и

плоскость управления. - Региональный внешний балансировщик нагрузки HTTP(S). Это региональная загрузка балансировщик, который реализован как управляемая служба на Envoy с открытым исходным кодом прокси. Это включает в себя расширенные возможности управления трафиком, такие как зеркалирование трафика, разделение трафика на основе веса, преобразования заголовков на основе запроса/ответа, и больше.Этот балансировщик нагрузки в настоящее время находится в Предварительный просмотр .

| Режим балансировки нагрузки | Рекомендуемые варианты использования | Возможности |

|---|---|---|

| Глобальный внешний балансировщик нагрузки HTTP(S) (Предварительный просмотр) | Используйте этот балансировщик нагрузки для внешних рабочих нагрузок HTTP(S) с

глобально рассредоточенные пользователи или серверные службы в нескольких регионах. | |

| Глобальный внешний балансировщик нагрузки HTTP(S) (классический) | Этот балансировщик нагрузки является глобальным на уровне Premium, но его можно настроить быть эффективным регионом на уровне Standard. В службе Premium Network уровень, этот балансировщик нагрузки предлагает балансировку нагрузки в нескольких регионах, направление трафика на ближайший работоспособный сервер который имеет пропускную способность и терминирует HTTP(S)-трафик как можно ближе возможно для ваших пользователей. В стандартной сети Уровень обслуживания, балансировка нагрузки осуществляется на региональном уровне. |

|

| Региональный внешний балансировщик нагрузки HTTP(S) (Предварительный просмотр) | Этот балансировщик нагрузки содержит многие функции существующий глобальный внешний балансировщик нагрузки HTTP(S) (классический), наряду с дополнительными расширенными возможностями управления трафиком. Используйте этот балансировщик нагрузки, если вы хотите обслуживать контент из только одна геолокация (например, для соблюдения нормативных требований) или если стандарт Уровень сетевых служб желателен. | Полный список см. в разделе Загрузка. особенности балансировки. |

Идентификация режима

Чтобы определить режим балансировщика нагрузки, выполните следующую команду:

Правила переадресации вычислений gcloud описывают FORWARDING_RULE_NAME

В выводе команды проверьте схему балансировки нагрузки, регион и сеть

уровень. В следующей таблице показано, как определить режим нагрузки.

балансир.

В следующей таблице показано, как определить режим нагрузки.

балансир.

| Режим балансировки нагрузки | Схема балансировки нагрузки | Правило переадресации | Сетевой уровень |

|---|---|---|---|

| Глобальный внешний балансировщик нагрузки HTTP(S) (Предварительный просмотр) | ВНЕШНЕЕ_УПРАВЛЯЕМОЕ | Глобальный | ПРЕМИУМ |

| Глобальный внешний балансировщик нагрузки HTTP(S) (классический) | ВНЕШНИЙ | Глобальный | СТАНДАРТ или ПРЕМИУМ |

| Региональный внешний балансировщик нагрузки HTTP(S) (Предварительный просмотр) | ВНЕШНЕЕ_УПРАВЛЯЕМОЕ | Задает регион | СТАНДАРТ |

Вместо,

необходимо удалить балансировщик нагрузки и создать новый.

Вместо,

необходимо удалить балансировщик нагрузки и создать новый.Архитектура

Следующие ресурсы необходимы для балансировки нагрузки HTTP(S) развертывание:

Только для региональных внешних балансировщиков нагрузки HTTP(S) , только прокси-сервер подсеть используется для отправлять соединения от балансировщика нагрузки к бэкендам.

Внешнее правило переадресации указывает внешний IP-адрес, порт, и целевой HTTP(S) прокси.Клиенты используют IP-адрес и порт для подключиться к балансировщику нагрузки.